Громыко А., Хеллман М. и др. Прорыв: Становление нового мышления. Советские и западные учёные призывают к миру без войн

Подождите немного. Документ загружается.

НЕИЗБЕЖНОСТЬ:

ГРОЗЯЩИЙ

КАТАСТРОФОЙ

КУРС

... 58

Заключение

Перенасыщенность

техническими

средствами

про

верки

и

контроля,

присущая

системе

стратегических

сил,

уменьшает

риск

возникновения

войны

в

результате

единичной

технической

оплошности.

Это,

вероятно,

сни

жает

опасность

войны

даже

в

случае

небольшого

коли

чества

изолированных

ошибок.

Когда

же

несколько

оши

бок

случается

одновременно,

ситуация

становится

бо

лее

тревожной.

Особенно

опасно,

когда

ложные

сигналы

появляются

во

время

кризиса

в

советско-американских

отношениях.

Подлинная

опасность

в

период

суэцких

событий

состояла

в

том,

что

совпадение

инцидентов

произошло

во

время

политического

кризиса.

В

ходе

кризиса,

когда

войска

будут

подняты

по

сигналу

тре

воги,

система

предупреждения

должна

справиться

с

распознаванием

и

интерпретацией

ряда

одновременных

событий.

Некоторые

из

них

будут

действительно

вызы

вать

тревогу,

другие

-

нет,

но

система

не

будет

в

со

стоянии

распознать

разницу.

В

таком

будущем

кризисе

эскалация

тревоги

может

привести

к

куда

более

тяжелым

последствиям,

чем

в

50-х

или

60-х

годах.

В

самом

широком

смысле

опасность,

угрожающая

всему

миру,

заключается

в

том,

что

сверхдержавы

имеют

огромные

ядерные

арсеналы.

Они

создали

самый

слож

ный

технический

комплекс,

который

можно

только

вооб

разить,

не

имея

возможности

полностью

его

контроли

ровать.

В

результате

сложилась

система,

напоминающая

механизмы

начала

ХХ

века.

Первую

мировую

войну

можно

было

ожидать

в

любое

время

в

течение

деся

тилетия,

предшествующего

1914

году.

Весьма

приме

чательно,

что

в

то

время,

когда

генеральные

штабы

стран

Европы

работали

над

созданием

мобилизацион

ных

планов,

чувство

безопасности

и

внутренней

само

успокоенности

доминировало

среди

общественности.

Несмотря

на

то

что

царило

ожидание

войны,

тот

факт,

что

она

еще

не

началась,

воспринимался

как

знак

того,

что

все

идет

хорошо.

Бертран

Рассел

напоминает

о

том,

что

отсутствие

крупных

войн

в

Викторианскую

эпоху

убаюкивало

народ

вымышленными

гарантиями

мира

на

вечные

времена.

Считал

ось,

что

никто

не

будет

столь

неразумным,

чтобы

начать

настоящую

войну.

НЕНАДЕЖНОСТЬ

КОНТРОЛЯ

НАД

ЯДЕРНЫМИ

СИЛАМИ

59

Внезапность

первой

мировой

войны

удивила

всех.

МеждУ

тем,

оглядываясь

назад,

следует

признать,

что

почти

ничего

другого

не

могло

произойти,

поскольку

мобилизационные

планы

и

гигантские

арсеналы

бьmи

подготовлены

на

протяжении

предшествующих

десяти

летий.

Сопоставимая

ситуация

существует

и

сегодня.

Компьютерные

системы

и

ядерная

война

Алан

Борнинг

Профессор

кафедры

прикладной

математики

Вашинггонского

универ

ситета

(Сиэттл).

Его

участие в

движении

«Профессионалы

компью

терной

техники

за

социальную

oтвeТCTвeннoc~

помогло

ему

со

здать

труд,

анализирующий

значение

неполадок

в

работе

ЭВМ

для

случайного

возникновения

ядерной

войны.

Ложные

тревоги

Во

вторник,

3

июня

1980

года,

в

1

час

26

минут

сис

тема

индикации

на

командном

пункте

Стратегического

военно-воздушного

командования

(СВВК)

близ

города

Омах

а

(штат

Небраска)

показала,

что

две

запущенные

с

подводных

лодок

баллистические

ракеты

приближают

ся

к

Соединенным

Шта1'ам

1.

Через

восемнадцать

секунд

система

показала

увеличившееся

число

таких

же

ракет.

Стратегическое

военно-воздушное

командование

связа

лось

с

Объединенным

командованием

ПВО

CeB~poaMe

риканского

континента

(нор

АД),

сотрудники

которого

сообщили,

что не

обнаруживают

никаких

признаков

нападения.

Через

короткий

промежуток

времени

сигналы

исчез

ли

с

экрана

системы,

однако

вскоре

экран

наблюдения

в

СВВК

снова

показал,

что

с

территории

Советского

Союза

в

сторону

ClIIA

запущены

межконтинентальные

баллистические

ракеты

.

На

этот

раз

экраны

наблюдения

в

Центре

управления

национальными

вооруженными

си

лами

в

Пентагоне

зафиксировали

запуск

раке'г

с

подвод

ных

лодок

.

Дежурный

начальник

системы

СВВК

отдал

приказ

всем

дежурным

экипажам

занять

места

в

бомбар

дировщиках

В-52

и

запускать двигатели

-

расчет

де

лался

на

то,

что

самолеты

смогут

быстро

подняться

в

воздух

и

избежать

уничтожения

на

земле

во

время

атомной

атаки

.

Наземные

установки

Были

приведены

в

состояние

полной

боевой

готовности,

а

самолет

управ

ления

боем

подготовлен

к

взлету.

На

Гавайях

в

воздух

КОМПЬЮТЕРНЫЕ

СИСТЕМЫ

И

ЯДЕРНАЯ

ВОЙНА

61

поднялся

размещенный

в

самолете

штабной

пункт

тихо

океанского

командования

-

он

должен Был

в

случае

необходимости

передавать

команды

военным

кораблям

США.

К

счастью,

в

ход

событий

вмешался

ряд

факторов,

вызвавших

у

участников

операции

сомнение

в

реаль

ности

нападения.

Через

3

минуты

12

секунд

после

начала

тревоги

команды

были

отменены.

Тревога

оказалась

ложной.

Командование

ПВО

Североамериканского

континен

та

оставило

систему

в

том

же

СОСТОянии

в

надежде

на

то,

что

ошибка

повторится

и

удастся

выявить

ее

причину.

Ошибка

действительно

повторилась

через

три

дня,

б

июня

в

15

часов

38

минут.

Стратегическое

воен

но-воздушное

командование

получило

сигнал

о

запуске

межконтинентальных

баллистических

ракет.

Снова

эки

пажи

заняли

места

в

самолетах,

снова

были

запущены

двигатели.

Проверка

показала,

что

причиной

этих

лОжных

тревог

оказался

выход

из

строя

одной

из

интегральных микро

схем

компьютера,

являющегося

частью

коммуникаци

онной

системы.

Дело

в том,

что

для

проверки

работо

способности

коммуникационной

системы

она

постоянно

испытывается

контрольными

сигналами,

которые

имеют

такую

же

форму,

как

сообщение

об

атаке,

но

с

нуле

вым

заполнением

для

числа

обнаруженных

ракет.

Когда

микросхема

вышла

из

строя,

система

стала

заносить

произвольные

числа

в

разряд

количества

обнаруженных

ракет

2.

С

учетом

краткос'ги

сроков

оповещения,

которые

в

лучшем

случае

измеряются

минутами,

современные

ядер

ные

вооруженные

силы

не

могут

функционировать

без

быстродействующих

компьютеров,

необходимых

для

ав

томатизации

процесса

оповещения,

управления

связью

и,

если

необходимо,

направления

ракет

к

целям.

На

сколько

надежны

компьютеры,

используемые

в

системе

командования

и

управления

ядерным

оружием?

Могут

ли

они

быть

достаточно

надежными?

Именно

эти

воп

росы

рассматриваются

в

данной

статье.

В

упомянутом

нами

случае

понятие

«надежность»

выходит

за

пределы

обеспечения

простой

работоспособ-·

ности

системы

и

распространения

на

сферу

назна

чения

системы

и

даже

на

действия

в

обстоятельствах,

НЕИЗБЕЖНОСТЬ:

грозящий

КАТАСТРОФОЙ

КУРС

... 62

которые

мы

можем

еще

не

знать.

До

какой

степени

мы

способны

определить

и

запрограммировать

наши

на

мерения

в

компьютерных

системах

таким

образом,

чтобы

охватить

все

возможные

обстоятельства?

Могут

ли

Со

ветский

Союз

или

Соединенные

Штаты

взять

на

себя

ответственность,

одобрив

стратегию,

способную

привести

к

непреднамеренному

началу

ядерной

войны

по

причине

неполадок

ЭВМ?

Как

будет

показано

ниже

-

не

могут.

Критерий

надежности

военных

компьютерных

систем,

неполадки

которых

могут

привести

к

термоядерной

ка

тастрофе,

должен

быть

выше

критерия

надежности

лю

бой

другой

системы

ЭВМ,

потому

что

размеры

возмож

ной

катастрофы

неизмеримо

велики.

Причины

ошибок

системы

Системы

ЭВМ

могут

выйти

ИЗ

строя

из-за

непра

вильно

заданных или

неполных

исходных

условий,

непо

ладок

в

аппаратной

части

системы,

неточностей

в

проек

тировании

аппаратуры,

ошибок

в

программном

обеспе

чении

и

ошибок,

допущенных

человеком,

например,

при

неправильном

обращении

с

компьютерной

техникой

WIИ

нenpавильном

ее

обслуживании.

Сложные,

обычно

высо

конадежные

системы

могут

выйти

из

строя

при

необыч

ном

сочетании

неполадок.

Неполадки

в

аппаратуре

являются

наиболее

частой

причиной

ошибок

системы.

Цримером

такой

ошибки

слу

жит

ложная

тревога

в

системе

НОРАД

в

июне

1980

года.

Отдельные

компоненты

системы

при

строгом

контроле

качества

и

проверке

могут

обладать

очень

высокой

на

дежностью,

однако

нет

оснований

считать,

что

в

большой

системе

никогда

не

выйдет

из

строя

ни

одна

деталь.

Поэтому

должна

использоваться

такая

техника,

которая

не

допускает

выхода

из

строя

отдельных

компонентов

системы.

Однако

при

создании

очень

сложных

систем

(примером

которой

и

является

командно-управляющая

система

военного

назначения)

никто

не

может

быть

аб

солютно

уверен

в

возможности

предотвращения

всех

не

поладок

и

вправильности

принятых

при

ее

констру

ировании

предположений

2,3,4.

К

тому

же

практика

дублирования

основных

компонентов,

которая

допуска

ет

их

выход

ИЗ

строя,

сама

по

себе

приводит

к

услож

нению

системы

и

обусловливает

ее

ошибки.

КОМПЬЮТЕРНЫЕ

СИСТЕМЫ

И

ЯДЕРНАЯ

ВОЙНА

63

Другим

потенциальным

источником

сбоя

является

ошибка

в

проектировании

аппаратуры.

В

этом

случае

проблема

выявляется

не

при

работе

системы

в

нормаль

ных

и

ожидаемых

условиях,

а

при

появлении

событий

неожиданных.

Очень

трудно,

например,

предвидеть

проб

лемы,

возникающие

из-за

неожиданного

совпадения

со

бытий,

самих

по

себе

редких.

Характер

систем

ЭВМ

таков,

что

основные

элементы

проектирования

новой

системы

встраиваются

в

ее

прог

раммное

обеспечение.

Как

правило,

программное

обес

печение

превосходит

сами

компьютеры

по

сложности и

стоимости.

Общеизвестно,

что

проверка

надежности

не

мОжет

сводиться

только

к

безошибочной

работе

про

граммы,

она

должна

планироваться

на

всех

стадиях

разработки

системы.

Так

же

как

и

в

отношении

надеж

ности аппаратуры,

существуют

классифицированные

критерии

для

разработки

технических

условий,

проек

тирования,

составления

и

испытания

<УГветственных

про

грамм.

И

даже

при таких

условиях

ошибки

могут

быть

внесены

в

программу

на

любой

стадии

ее

разработки,

т.

е.

при

постановке

исходных

технических

задач,

при

проектировании,

эксплуатации,

испытании,

наладке

или

обслуживании

5,6,7.

Ошибки

в

разработке

исходных

технических

данных

системы,

как

аппаратуры,

так

и

программного

обеспе

чения,

по

всей

вероятности,

имеют

наиболее

пагубные

последствия.

Мы

должны

предвидеть

все

обстоятельст

ва,

в

которых

система

может

использоваться,

и

описать

все

действия,

которые

должны

быть

предприняты

си

стемой

в

каждой

ситуации.

В сложной

системе

все

эти

обстоятельства

предвидеть

невозможно.

Мы

можем

быть

уверены

в

надежности

сложных

систем

только

после

их

длительного

испытания

в

условиях

реального

ис

пользования.

Поскольку

история

пока

знает

не

так

мно

го

случаев

чрезвычайной

меЖдУнародной

напряженно

сти,

требовавшей

приведения

ядерных

арсеналов

в

бое

вую

готОвность

(что

всегда

чрезвычайно

опасно),

ко

мандно-управляющие

системы

ядерного

оружия

не

мог

ли

быть

испытаны

в

условиях

реального

применения.

Испытание

в

экстремальных

условиях,

в

которых

подоб

ные

системы

должны

функционировать

(т.

е.

в

усло

виях

краткосрочной

или

затяжной

атомной

войны),

принципиально

невозможно.

Между

тем

именно

непрове-

НЕИЗБЕЖНОСТЬ:

грозящий

КАТАСТРОФОЙ

КУРС

...

64

ренность

В

экстремальных

условиях

предупреждающих

и

управляющих

систем

вызывает

большое

беспокойство.

Ошибки

могут

быть

внесены

в

систему

при

вопло

щении

исходных

технических

условий

в

конструкцию,

а

также

при

разработке

программного

обеспечения.

В

этом

случае

ОСНОВНОй

проблемой

становится

сложность

системы.

Тот,

кто

работал

над

крупной

компьютерной

системой,

знает,

насколько

сложным

является

процесс

ее

разработки.

Как

правило,

никто

не

может

понять

досконально

всю

систему.

Корректировка

программы,

например

при

устранении

неполадок

или

при

замене

компонентов

системы,

сама

по

себе

несет

высокую

ве

роятн9СТЬ

(обычно

от

20

до

50 % )

введения

новой

ошибки

в

программу.

Еще

одним

источником

неполадок

являются

ошибки,

допускаемые

человеком.

Несмотря

на

длительное

обу

чение

и

всевозможные

предупреждения,

люди

могут

делать

ошибки,

особенно

в

условиях

экстремальных

психических

нагрузок.

9

ноября

1979

года

магнитная

лента,

содержащая

данные

по

имитации

атаки

и предназначенная

для

испы

тания

системы

оповещения

о

ракетном

нападении,

была

вставлена

в

компьютер

системы

НОР

АД,

который

по

ошибке

оператора

был

подключен

к

действующей

де

журной

системе

слежения.

В

результате

в

течение

после

дующих

шести

минут

1

О

тактических

истребителей

были

подняты

по

боевой

тревоге

с

баз

северной

части

США

и

с

территории

Канады

J.

Вероятность

внесения

ошибки

оператором

значи

тельно

усиливается

под

влиянием

алкоголя

или

нарко

тиков.

Л.

Дюма

8

приводит

неутешительную

статистику

употребления

алкоголя

и

наркотиков,

а

также

ненормаль

ного

поведения

лиц

американского

военного

персонала,

имеющих

доступ

к

ядерному

оружию.

Алкоголизм

яв

ляется

также

одной

из

серьезных

проблем

в

Советском

Союзе

и

может

проявляться

среди

советского

военного

персонала.

Поучительные

ошибки

Весьма

полезно

проанализировать

некоторые

поучи

тельные

ошибки

в

системах,

рассчитанных

на

высокую

КОМПЬЮТЕРНЫЕ

СИСТЕМЫ

И

ЯДЕРНАЯ

ВОЙНА

65

наДежность.

Почти

все

приводимые

примеры

касаются

американских

систем,

поскольку

автор

имеет

данные

только

о

них.

Однако

следует

предполагать,

что

аналогич

ные

ошибки

могут

иметь

место

в

СССР

и

других

промыш

ленно

развитых

странах.

Примером

ошибки,

связанной

с

работой

аппаратуры,

может

служить

случай

ложной

тревоги,

происшедшей

в

июне

1980

года

в

НОРАД

и

описанной

в

начале

этой

статьи

.

Эта

ложная

тревога

иллюстрирует

также

ошибку

в

проектировании

аппаратуры

.

Серьезной

оплошностью

в

рассматриваемом

случае

явилось

то,

что

крити

ческие

данные,

содержащие

сигнал

о

ядерной

атаке,

были

посланы

без

проверки

с

помощью

стандартной

и

общеизвестной

техники

проверки

ошибок

1.

Другой

пример

неполадок

в

аппаратуре

касается

полного

выхода

из

строя

компьютерной

системы

связи

министерства

обороны

США

в

октябре

1980

года.

Эта

ошибка

прои

зошла

вследствие

необычных

неполадок

в

аппаратуре,

из-за

которых

одно

из

звеньев

системы

переключило

на себя

и

израсходовало

все

ресурсы,

предназначенные

для

других

звеньеЕ.

Упомянутая

система

была

рассчи

тана

на

высокую

мобильность

переключения

ресурсов

с

целью

предотвращения

выхода

из

строя

всей

систе

мы

из-за

неполадок

в

одном

из

звеньев

аппаратной

части.

Однако

заложенная

в

систему

ошибка

прояви

ла

себя

только

через

несколько

лет.

Запуск

первого

челночного

космического

летатель

ного

аппарата

был

задержан

в

последнюю

минуту

перед

стартом

из-за

неполадок

в

программе.

В

целях

повыше

ния

надежности

челночный

космический

аппарат

был

ос

нащен

четырьмя

дублирующими

друг

друга

навигацион

ными

вычислительными

устройствами,

каждое

из

кото

рых

работало по

одинаковой

программе,

в

сочетании

с

пятым

вспомогательным

компьютером,

работающим

по

другой

системе.

Вероятность

того,

что

компьютеры

при

включении

не

будут

работать

синхронно,

состав

ляла

один

шанс

из

67.

Эта

аварийная

ситуация

имеет

ряд

заслуживающих

внимания

особенностей.

Во-пер

вых,

несмотря

на

особое

внимание,

удеJlяемое

в

косми

ческой

электронике

вопросам

надежности,

система

все

же

допустила

ошибку

в

программе.

Во-вторых,

эта

ошиб

ка

возникла

из-за

дополнительной

сложности,

внесен

ной

избыточностью

конструкции

с

целью

повышения

на-

НЕИЗБЕЖНОСТЬ:

ГРОЗЯЩИЙ

КАТАСТРОФОЙ

КУРС

..•

66

дежности.

В-третьих,

неисправность

проявилась

при

по

пытке

решения

предыдущей

проблемы.

Существует

много

примеров

ошибок,

оБУСЛОRЛенных

неправильными

или

неполными исходными

условиями

конструирования

систем.

5

октября

1960

года

с

достовер

ностью

99,9%

система

оповещения

НОРАД

показала,

что

на

Соединенные

Штаты

предпринята

массированная

ядерная

атака

со

стороны

Советского

Союза.

В

действи

тельности

же

система

раннего

предупреждения

о

ракет

но-ядерном

нападении,

находящаяся

в

Туле

(Гренлан

дия),

среагировала

на

восходящую

Луну.

Оказалось,

что

никто

не

подумал

о

Луне, когда

состаRЛЯЛИСЬ

исход

ные

технические

задачи

работы

системы.

Космический

корабль

«Джемини-

v »

приземлился

на

расстоянии

100

миль

от

намеченного

пункта

потому,

что

программа

была

составлена

без

учета

вращения

Земли

вокруг

Солн

ца;

другими

словами,

программа

бьmа

основана на

не

правильной

модели.

В

1979

году

пять

атомных

реакторов

были

закрыты

после

обнаружения

ошибки

в

программе,

предназначен

ной для

прогнозирования

поведения

реакторов

при

зем

летрясении.

Оказалось,

что

в

одной

из

подпрограмм

вместо

суммы

абсолютных

величин

ряда

чисел

включе

на

их

арифметическая

су-мма.

Впоследствии

вина

за

эти

ошибки

была

возложена

на

дисфункцию

отдельных

компонентов

системы, непра

вильную

конструкцию

или

на

промах

человека -

как

почти

всегда

бывает

в

подобных

случаях.

Однако

дей

ствительная

причина

потенциальных

аварий

-

слож

ность

системы и

наша

неспособность

предвидеть

и

иск

лючиTь

возможность

любых

ошибок.

Что

можно

сказать

о

вероятных

ошибках

в

совет

ских

системах

предупреждения?

Я

не

могу

с

полной

уверенностью

говорить

о

том,

были

ли

допущены

подоб

ные

ошибки,

ПОСКОЛЬКУ,

даже

если

они

и

были,

по

сей

день

эти

данные

не

опубликованы.

Однако

случай

с

ко

рейским

авиалайнером,

который

бьm

сбит

над

террито

рией

СССР

через

два

с

лишним

часа

после

того,

как

он

вторгся

в

воздушное

пространство

СССР

и

уже

почти

по

кидал

его,

показал,

что

советские

командно-управляю

щие

системы

тоже

не

свободны

от

проблем.

Гибель

нескольких

американских

и

советских

космо

навтов,

а

также

аварии

на

АЭС

в

США,

на

острове

Три

КОМПЬЮТЕРНЫЕ

СИСТЕМЫ

И

ЯДЕРНАЯ

ВОЙНА

67

Майл

Айленд,

и

в

СССР,

в

Чернобыле,

показывaIOТ

сопоставимую

степень

аварийности

даже

в

высокона

дежных

системах

обеих

стран.

Случаи,

подобные

тем,

что

произошли

на

острове

Три

Майл

Айленд

7

и

в

Чернобыле,

трагическому

взрыву

космического

корабля

((Челленд

жер»

в

1986

году,

аварии

в

энергосети

северо-восточной

части

США

в

1965

году,

ЯRЛяются

печальными

напо

минаниями

о

несовершенстве

техники.

Персnек:гuвы

усовершенствования

Каковы

перспективы

в

деле

повышения

надежности

военных

компьютерных

систем?

Значительный

прогресс

может

быть

достигнут

при

использовании

более

совре

менных

систем

компьютеров

и

программного

обеспече

ния

5,6,9.

Система

типа

той,

которая

была

использо

вана

в

НОРАД

и

в

1980

году

включала

устаревшие

ком

пьютеры

60-х

годов,

передавая

критические

данные

без

проверки

возможных

ошибок,

не

может

считаться

совре

менной.

Конечно,

переход

на

более

современную

техни

ку

может

помочь,

но

каковы

практические

и

теоре

тические

пределы

надежности

сейчас

и

в

будущем

де

сятилетии?

Министерство

обороны

США

предпринимает

попытки

разработки

новой

теории

создания

программ

и

поставки

их

военным

подрядчикам.

Примерами

таких

попыток служат

«Техника

программирования

доступных

и

надежных

систем»

и

основание

института

програм

много

обеспечения

при

Университете

Карнеги

-

Мел

лона.

Использование

новых

методик

уменьшит,

но

пол

ностью

не

ликвидирует

ошибки

на

стадии

перехода

от

технических

условий

к

программам.

В

долгосрочных планах

намечается

усилить

надеж

ность

компьютерных

систем

5

за

счет

формальных

мер,

таких,

как

проверка

правильности

програмМbl,

автома

тическое

программирование

и проверка

совместимости

конструктивных

элементов.

При

проверке

правильности

программы

человек

или

компьютер

математически

про

веряет

соответствие

программы

формальным

требова

ниям,

преДЪЯRЛяемым

к

этой

программе.

При

автома

тическом

программировании

программа

составляется

компьютером

по

заданным

техническим

условиям.

При

проверке

совместимости

элементов

доказывается,

что

формальные

технические

условия

УДОRЛетворяют

постав-

НВИЗБВЖНОСТЬ:

грозящий

КАТАСТРОФОЙ

КУРС

...

68

ленным

требованиям,

например

в

отношении

безопас

ности

или

допусков на

отклонения.

Тем

не

менее

техника

проверки

и

автоматического

программирования

не

может

решить

самую

трудную

и

неподатливую

проблему

составления

программ

для

решения

сверхсложных

задач,

таких,

как

командно

управляющие

функции,

определяющие

поведение

круп

ной

военной

системы.

Как

можно

гарантироватъ,

что

технические

условия

сами

по

себе

верны

и

ЧТО

ОБИ предписывают

то,

что

ожидается

от

системы'!

Возможны

ли

события,

которых

не

предвидели

в

момент

составления

технических

усло

вий'!

Прсверка

npaвильНОСТИ,

например,

показывает

лишь

то,

что

одно

формальное

описание

(технические

усло

вия)

эквивалентно

другому

формальному

описанию

(про

грамме).

Такая

проверка

не

определит,

что

технические

условия

отвечают

нечетко

сформулированНbIМ

запросам

потребителя

или

что

система

будет

ненадежно

рабо

тать

в

ситуа~

невообразимых

при

составлении

тех

нических

условий.

Так,

ложная

тревога

1960

года

показа

ла,

что

даже

при

удовлетворении

всех

технических

тре

бований

система

окажется

бесполезной,

если

при

сос

тавлении

технических условий

никто

не

подумает

о влия

нии

восходящей

Луны

на

сигналы

системы.

Поэтому

термин

.upoвepKa

правильносТИ»

в

данном

случае не

соответствует

действительности

и

должен

быть

заме

нен

на

более

скромный

-«проверка

относительной

сов-

местимости

•.

повышниеe

как

практических,

так

и

теоретических

пределов

надежности

наталкивается

на

вышеупомяну

тую

проблему,

связанную

с

постановкой

технических

условий.

Она

стала

основным

и

долгосрочным

препят

ствием на

пути

создания

надежных

и

сложных

систем.

Ответы

на

такие

критические

вопросы,

как

«Сущест

вуют

ли

какие-либо

внешние

события,

о

которых

мы

прос

то

не

подумали'!»

или

«Будет

ли

система

делать

то,

что

мы

от

нее

ожидаем'!»,

выхдятT

за

пределы

сферы

фор

мальных

систем.

Системы

ЭВМ

(включая

искусствен

ный

интеллект)

снискали

славу

систем,

которым

не

при

суще

понятие

здравого

смысла:

сама

по

себе

система

не

покажет,

что

произошла

ошибка

и

что

пределы

ее

возможнос:reй

превышны.

КОМПЬЮТЕРНЫЕ

СИСТЕМЫ

И

ЯДЕРНАЯ

ВОЙНА

69

Выводы

Можно

ли

полагаться

на

надежность

жизненно

важ

ных

компьютерных

систем,

в

частности

кома}fДНо-управ

ляющих

систем

ядерного

оружия'!

В

настоящий

момент

довольно

маловероятно,

что

отдельная

ошибка

компью

тера

или

человека

может

вызвать

серьезный

риск

ядер

ной

войны.

Однако

впОлне

вероятно,

что

риск

может

возникнуть

в

результате

совокупного воздействия

таких

факторов,

как

ситуация

меЖдУнародного

кризиса,

взаим

но

усиливающие

друг

друга

тревоги

и

подозреlШЯ

сторон,

ошибки

компьютерных

систем,

ДИСфуllКЦИя

ЭВМ

или

ошибка,

допущенная

человеком.

Одна

из

постоянных

тенденций

гонки

вооружений

-

создание

ракет

все

большей

и

большей

точности.

Эта

тенденция

усиливает

давление,

побуждающее

СТОрОВ:Ы:

принять

стратегию

запуска

по

предУпреждеllИЮ.

Такая

стратегия

не

оставляет

времени

на определение

реаль

ности

угрозы

или

выяснение,

не

вызвана

ли

тревога

ошибкой

компьютера.

В

результате

приходится

в

еще

большей

степени

полагаться

на

надежность

предУпре

дительных

и

командных

систем

в

США

и

СССР.

Размещение

точных

ракет

вблизи территории

предпо

лагаемого

противника

лишь

усугубляет

эту

проблему.

Внедрение

экзотических

систем

вооружения,

таких,

как

СОИ,

оснащенных

быстродействующими

ЭВМ

и

ис

кусственным

интеллектом,

может

привести

к

войнам,

управляемым

в

основном

компьютерами

9.

На

что

же

остается

полагаться

при

таких

обстоятельствах'!

Ко

нечно,

возможны

разные

технические

усовершенство

вания

в

компьютерных

системах

управления

ядерным

оружием.

Я,

однако,

не

уверен

в

том,

что

добавление

все

новых

усовершенствований

такого

рода

сможет

гаранти

ровать

надежную

работу

систем.

Проблема

ОСтается

фун

даментальной

вследствие

невозможности

испытаний

в

реальных

условиях

ошибок

человеческого

разума

в

мо

мент

экстремальной

напряженности

и

кр~зиса

и

нашей

неспособности

предвидеть

все,

что

может

случиться

в

сложных

и

незнакомых

ситуациях.

Мы

должны

отдавать

себе

отчет

о

пределах

возможностей

техники.

Угроза

ядерной

войны

-

это

ПОлитическая

проблема,

и

ее

устра

нение

должно

быть

гарантировано

политическими

сред

ствами,

подвластными

человеческому

разуму.

Ложные

тревоги:

в

чем

их

опасность?

JIинн:

Ceннoтr

Профессор

математики

ИЛЛИНОЙСКОГО

университета

(Кормзл,

штат

Иллииойс)

,

член

Математической

ассоциации

Америки,

Американ

ского

общества по

исследованию

проблем

управления

и

Ассоциации

женщин-математиков.

Совпадение

сигналов

ложной

тревоги

Краткая

история

атомного

века

изобилует

примерами

ложныx

атомных

тревог,

когда

радар

принимал

стаю

гусей

за

взмывшие

в

ВОЗдУх

ракеты,

лебедей

-

за

МИГов,

восходящую

Луну

-

за

приближающиеся

меж

континентальные

баллистические

ракеты,

а

программу

с

записью

учебной

тревоги,

случайно

оставленную

в

компьютере,-

за

боевую

тревогу.

Ложные

тревоги

стали

явлением

настолько

частым,

что

их

перестали

принимать

всерьез,

и

поэтому

опасность

случайного

возникновения

из-за

них

войны

в

целом

маловероятна.

Тем

не

менее

имеется

достаточно

оснований

для

беспо

койства.

Как

следует из

данных,

предоставляемых

для

общего

~сведения

американским

правителъством

на

основании

Закона

о

свободе

информации,

за

период

с

1977

по

1984

год

произошло

1152

ложные

тревоги

средней

степе

ни

серьезности.

Другими

словами,

каждую

неделю

в

сред-

~

I

нем

принимается

около

трех

сигналов

ложнои

тревоги

.

При

обнаружении

возможного

запуска

ракеты

или

при

появлении

необычной

информации

от

предУпреждающих

датчиков

немедленно

организуется

совещание

по

телефо

ну

для

оценки

потенциальной

угрозы.

Сигналы

ложной

тревоги

являются

настолько

секретной

темой,

что

прави

телъство

США

перестало

публиковать

соответствующие

дaHны,'

а

советская

сторона

и

ранее

не

публиковала

никаких

сведений

на

этот

счет.

Тем

не

менее,

исходя

из

данных

одной

стороны,

вероятно

предположить,

что

другая

сторона

имеет

такую

же

стабильную

степень

возникновения

сигналов

ложной

тревоги.

ЛОЖНЫЕ

ТРЕВОГИ:

В

ЧЕМ

их

ОПАСНОСТЬ?

71

Как

отмечалось

выше,

сигналы

ложной

атомной

тре

воги

-

дело

обычное

и

не

вызывающее

чрезмерного

беспокойства.

Новая

и

потенциально

опасная

ситуация

возникает

в

том

случае,

когда

второй сигнал

ложной

тревоги

возникает

раньше,

чем

выяснен

предыдУЩИЙ.

Два

почти

одновременно

поступивших

сигнала

подкреп

ляют

друг

дРуга

и

могут

привести

к

катастрофическим

последствиям.

Детальное

описание

опасностей,

таящихся

в

такой

многократной

ошибке,

читатель

найдет

в

статье

Брэкена,

включенной

в

эту

книгу.

Частое

появление

сигналов

ложной

тревоги

делает

возможность

совпадения

сигналов

вполне

вероятной.

Я

проанализировала

такую

вероятност~

используя

дан

ные

о

ложныx

тревогах,

полученные

от

Объединенного

командования

ПВО

Североамериканского

континента

(ПОРАД)

,

точнее

-

от

системы

дальнего

обнаружения

в

рамках

указанного

командования.

Полный

математи

ческий

анализ

включен

в

другие

мои

работы

2,7,

а

данная

статья

ограничивается

изложением

результатов.

Проблема

совпадения

сигналов

ложной

тревоги

мо

жет

быть

проанализирована

с

помощью

математических

приемов

так

называемой

теории

очередности.

Нам

всем

знакомо

неприятное

ожидание

в

длинных

очередях,

будь то

в

магазине

или

к

телефонной

линии.

Теория

очередности

была

разработана

для

анализа

таких

ситуа

ций

и

выработки

компромиссных

решений

междУ

потре

бителем

и

обслуживающим

персоналом

в

отношении

приемлемого

времени

ожидания.

Увеличение

обслужива

ющего

персонала

сократит

ожидание,

но увеличит

затра

ты.

В

нашей

модели

роль

потребителей

выполняют

сигна

лы

ложной

тревоги,

а

функция

обслуживающего

персо

нала

возложена

на

командную

и

управляющую

аппара

туру,

имеющую

дело

с

этими

сигналами.

Совпадение,

или

перекрытие,

сигналов

соответствует

образованию

очереди,

которая

вынуждена

ожидать

обслуживания.

Такая

ситуация

возникает,

если

новый

сигнал

ложной

тревоги

поступает,

когда

предыдУЩИЙ

еще

не

разре

шен

(не

«обслужен»)

командной

и

управляющей

си

стемой.

Хотя

среднее

время

разрешения

сигнала

ложной

тревоги

не

публиковалось

в

открытой

печати,

из

ряда

докладов

следУет,

что

оно

составляет не

менее

минуты.

Известно

также,

что

по

крайней

мере один

из

таких

НЕИЗБЕЖНОСТЬ:

ГРОЗЯЩИЙ

КАТАСТРОФОЙ

КУРС

...

72

сигналов

оставался

неразрешенным

в

течение

шести

ми

нут.

В

моей

модели

я

использовала

среднюю

величину

этих

двух

чисел,

т. е.

3,5

МИНУТЫ,

которые

были

при

няты

за

время

разрешения

сигнала.

Среднее

время

до

возможного

перекрытия

двух

сигналов

ложной

тревоги

также

может

быть

подсчитано

2.

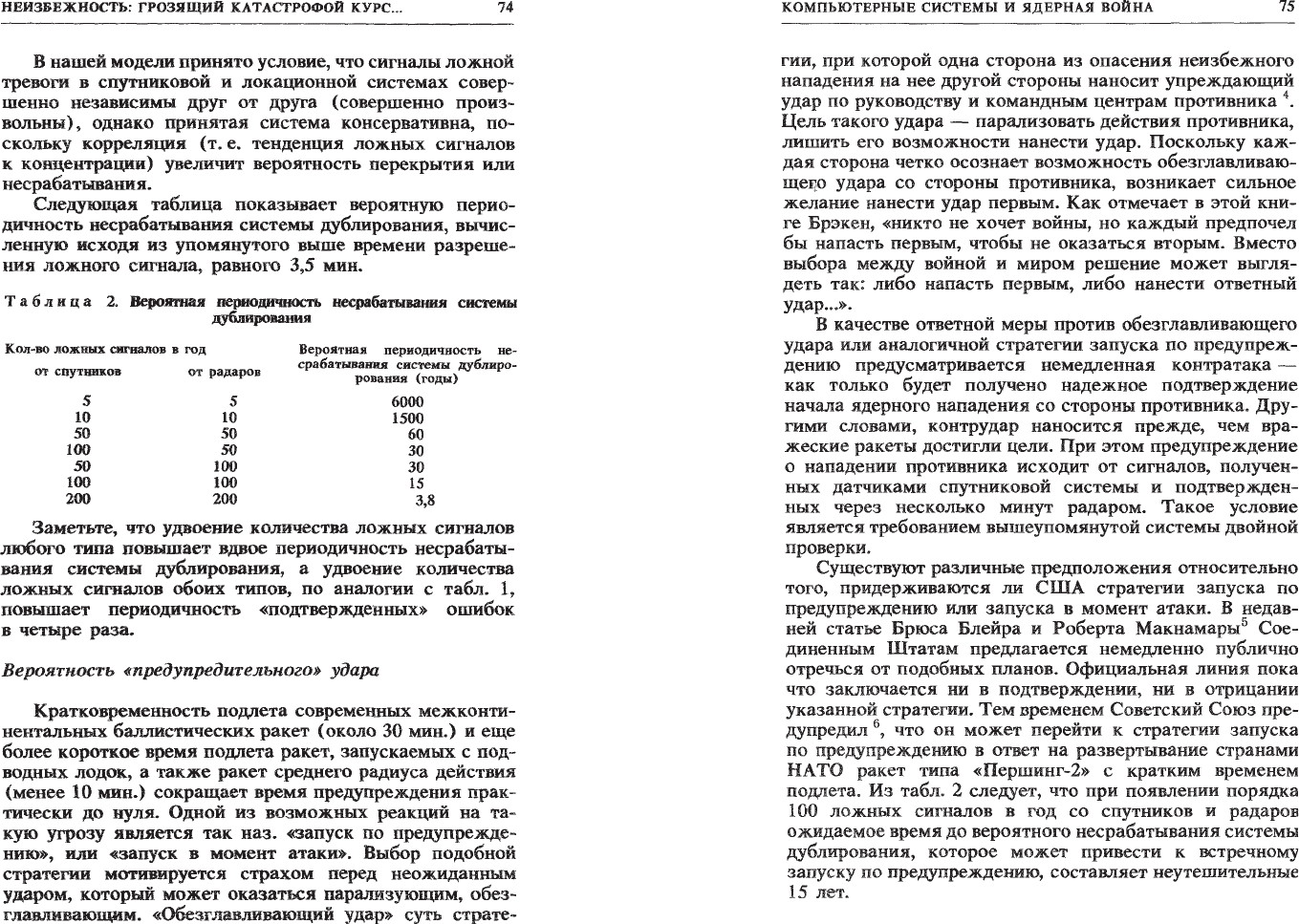

Результаты

такого

под

счета

представлены

в

табл.

1.

Хотя

полученные

данные

зависят

от

принятого

времени

разрешения

сигнала,

мои

общие

выводы

останутся

правильными,

если

время

раз

решения

сигнала

будет

выбрано

в

интервале

между

одной

и

шестью

минутами.

При

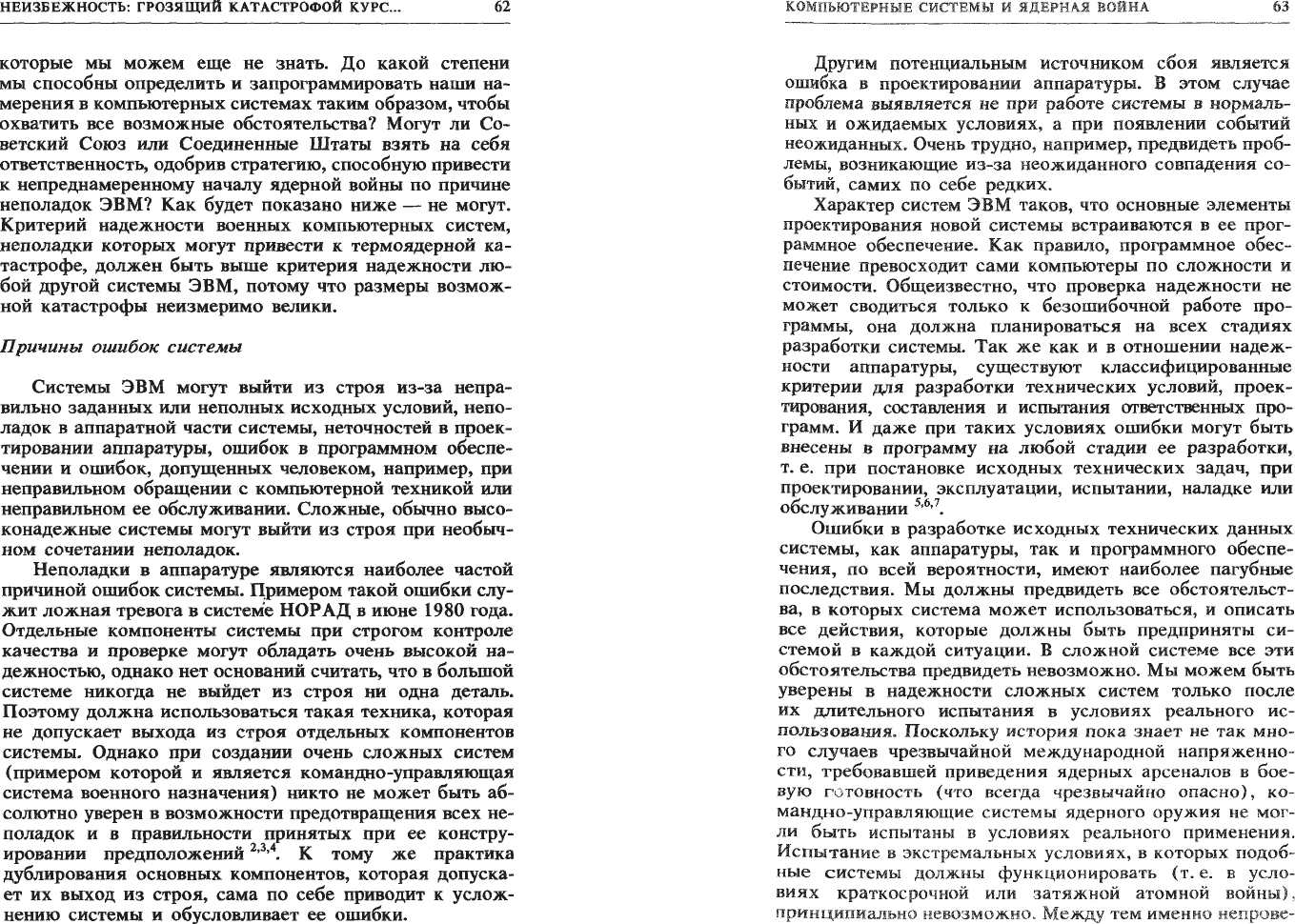

поступлении

в

среднем

144

сигналов

ложной

тревоги

в

год

(что

соответствует

данным

НОРАД

за

период

1977-1984

гг.)

перекрытие

двух

сигналов

долж

но

происходить

каждые

семь

лет.

Если

учитывать

менее

серьезные

сигналы

ложной

тревоги,

чем

те,

которые

заслуживают

созыва

оперативного

совещания,

то

пере

крытие

будет

возникать

гораздо

чаще

по

следующим

причинам.

Во-первых,

каждый

год

количество

менее

серьезных

ложных

сигналов

достигает

нескольких

тысяч.

Во-вторых,

удвоение

числа

ложных

сигналов

учетверяет

периодичность

их

перекрытия.

Математическое

объясне

ние

этого

явления

не

входит

в

задачу

данной

статьи,

однако

основной

принцип

прослеживается

в

табл.

1.

Например,

удвоение

количества

ложных

тревог

со

150

до

300

в

год

учетверяет

периодичность

возможных

пере

крытий

-

с

одного

за

каждые

6,7

года

до

одного

за

каждые

1,7

года.

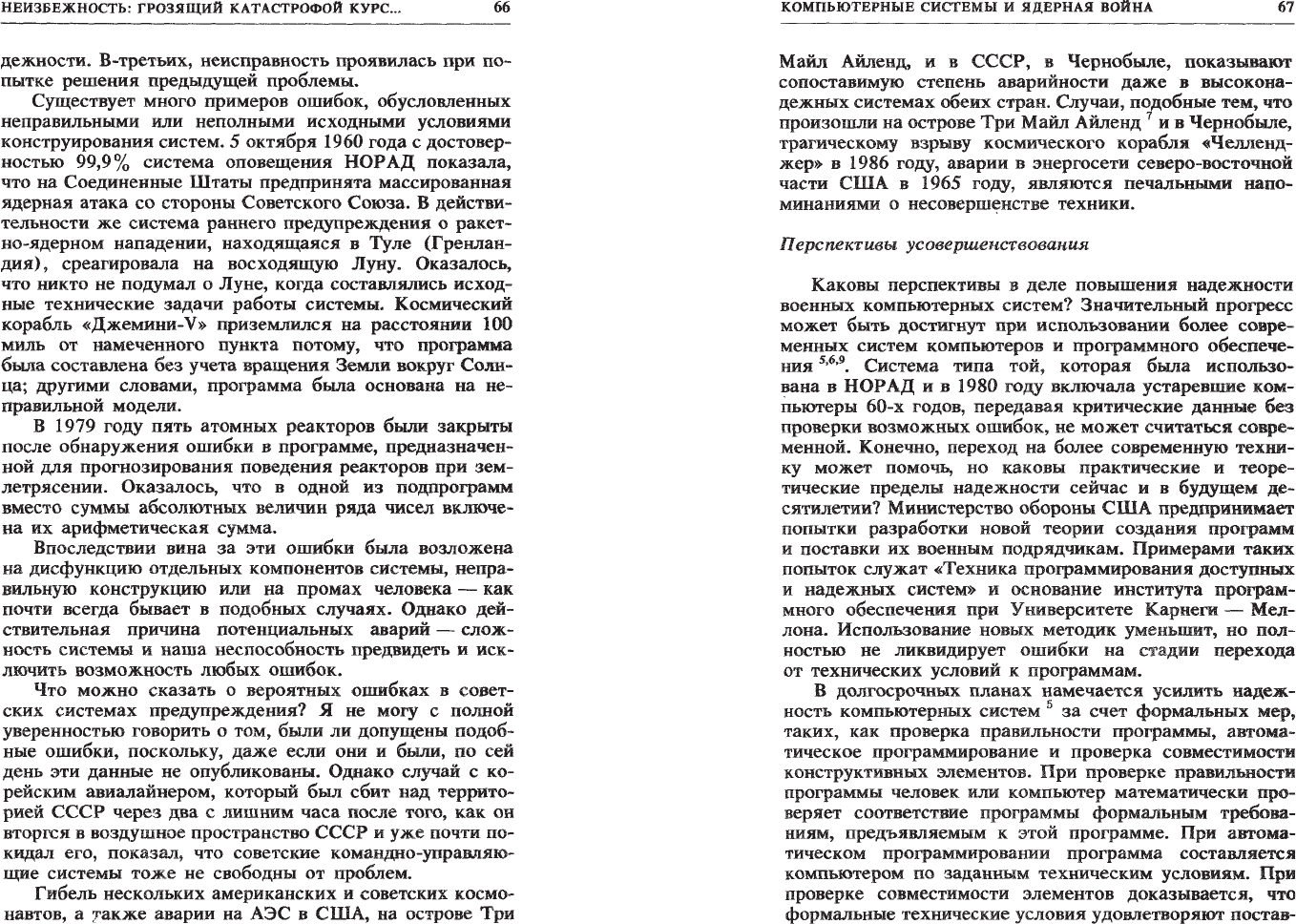

т

а

б

л

и

ц

а

1.

ВеРОЯ1НaJI

периодичность

перекрытия

двух

cиrнaJIOII

ложной

тpeвom

Кол-во

ложных

тревог

в

год

5

10

50

100

150

200

300

Вероятная

периодичность

перекрытия

двух

сигналов

(годы)

6000

1500

60

16

6,7

3,8

1,7

Более

частые

по

своей

природе

ложные

тревоги

обычно

считаются

менее

серьезными,

однако

с

учетом

учетверяемости

перекрытия

и

нестабильности

в

систе

мах

военного

командования

и контроля

(см.

статьи

КОМПЬЮТЕРНЫЕ

СИСГВМЫ

И

ЯДЕРНАЯ

ВОЙНА

73

Брэкена

и

Раушенбаха

в

этой

книге)

даже

такие

не

серьезные

ложные

тревоги

могут

оказаться

весьма

опас

ными.

НеЭффективность

системы

двойной

nроверки

в

обнару)Кении

ракет

Используя

теорию

очередности,

можно

объяснить

еще

один

режим

несрабатывания

системы

оповещения.

Система

оповещения

состоит

в

основном

из

двух

ком

понентов:

-

спутниковых

систем

для

обнаружения

инфракрас

ного

следа,

оставляемого

работающим

двигателем

раке

ты,

и

-

радарных

систем,

выявляющих

приближающиеся

межконтинентальные

ракеты

и

следящих

за

их

продви

жением.

Понимание

серьезных

последствий

ошибочного

сиг

нала

о

ядерном

нападении

вынуждает

прибегать

к

дубли

рованию

систем

обнаружения

ракет.

Двойная

проверка

(дублирование)

состоит

в

том,

что

сигнал

о

нападении,

обнаруженный

датчиками

сП}'ТНИковой

системы,

должен

быть

подтвержден

радиолокационной

системой

3.

Спут

ники

обнаруживают

ракету

в

момент

запуска, в

то

время

как

радарные

установки,

которые

находятся

на

террито

рии

страны,

подвергшейся

нападению,

обнаруживают

ракету

несколько позже,

а

именно

в

момент,

когда

она

попадает

в

их

поле

зрения.

В

нашей

модели

система

дублирования

не

спасает

положения,

если

радар

подаст

ошибочный

сигнал

тревоги

прежде,

чем

будет

разрешен

последний

ложный

сигнал

со

спутниковых

систем.

При

такой

последовательности

событий

обнаружение

ракеты

спутником

будет

как

бы

подтверждено

радарным

об

наружением.

Если

мы

вновь

обратимся

к теории

очередности

и

сопоставим

сигналы

ложной

тревоги

с

потребителями,

а

их

разрешение

с

временем

обслуживания,

мы

полу

чим

два

вида

потребителей

-

спутниковые

«потребите

лю)

и

радарные

«потребители..

Система

дублирования

не

срабатывает,

если

новый

радарный

«потребителы)

окажется

в

ситуации,

при

которой

последний

спутнико

вый

«потребите~

все

еще

находится

в

СТадии

обслу

живания

(разрешения).

НЕИЗI>ЕЖНОСТЬ:

ГРОЗЯЩИЙ

КАТАСТРОФОЙ

КУРС

...

74

в

нашей

модели

принято

условие,

что

сигналы

ложной

тревоги

в

спутниковой

и

локационной

системах

совер

шенно

независимы

друг

от

друга

(совершенно

произ

вольны)

,

однако

принятая

система

консервативна,

по

скольку

корреляция

(т.

е.

тенденция

ложных

сигналов

к КОlЩентрации)

увеличит

вероятность

перекрытия

или

несрабатываиия.

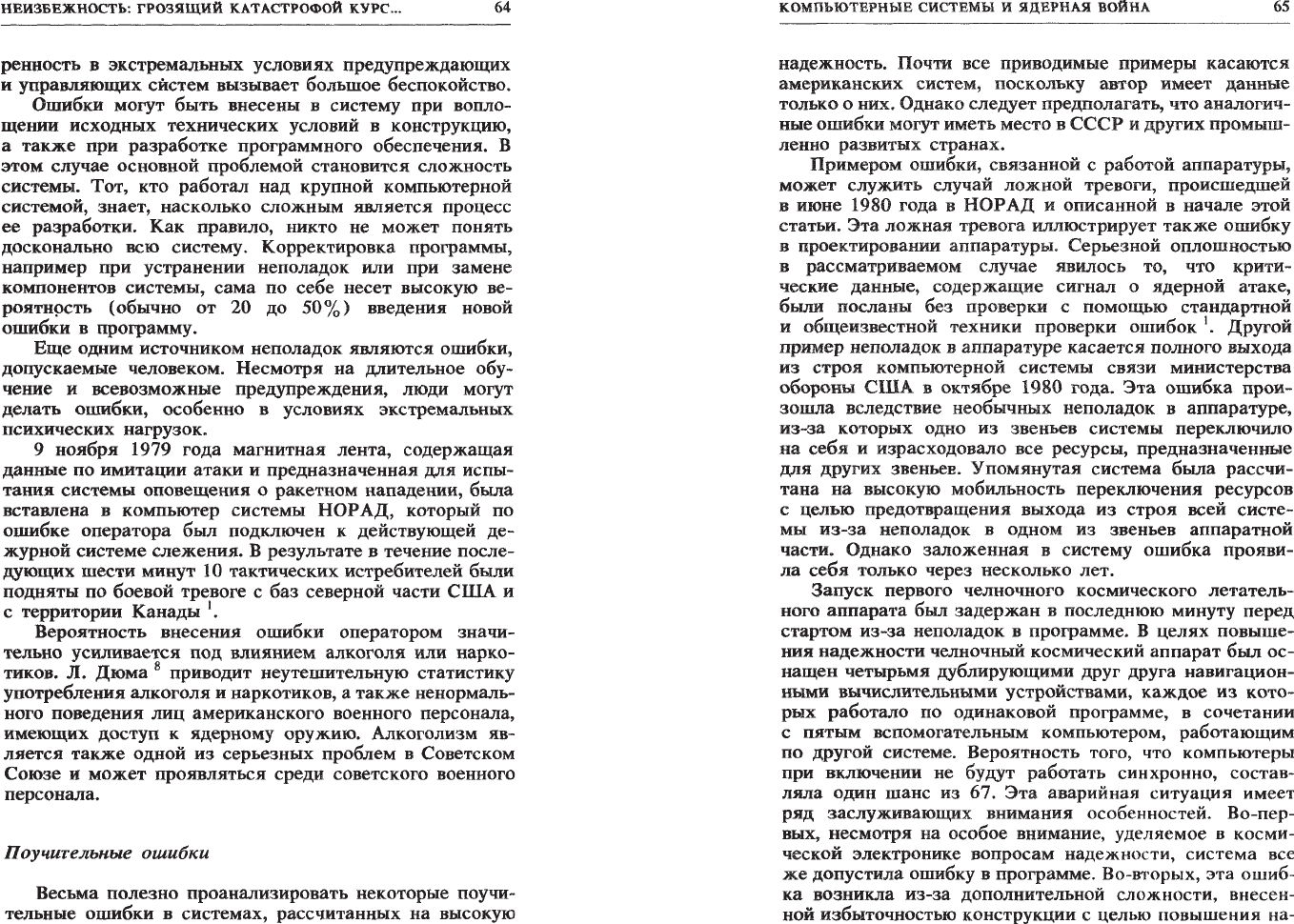

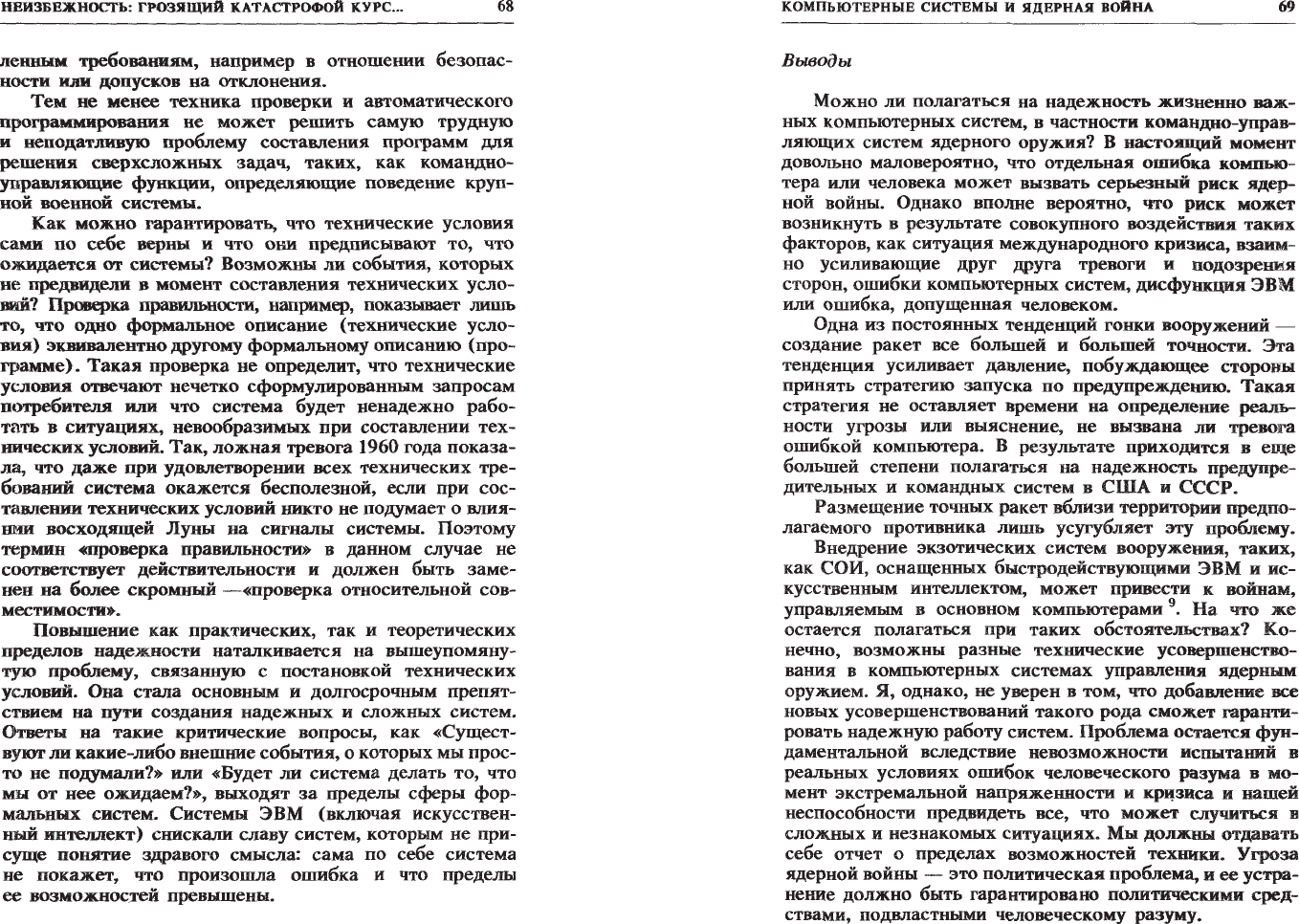

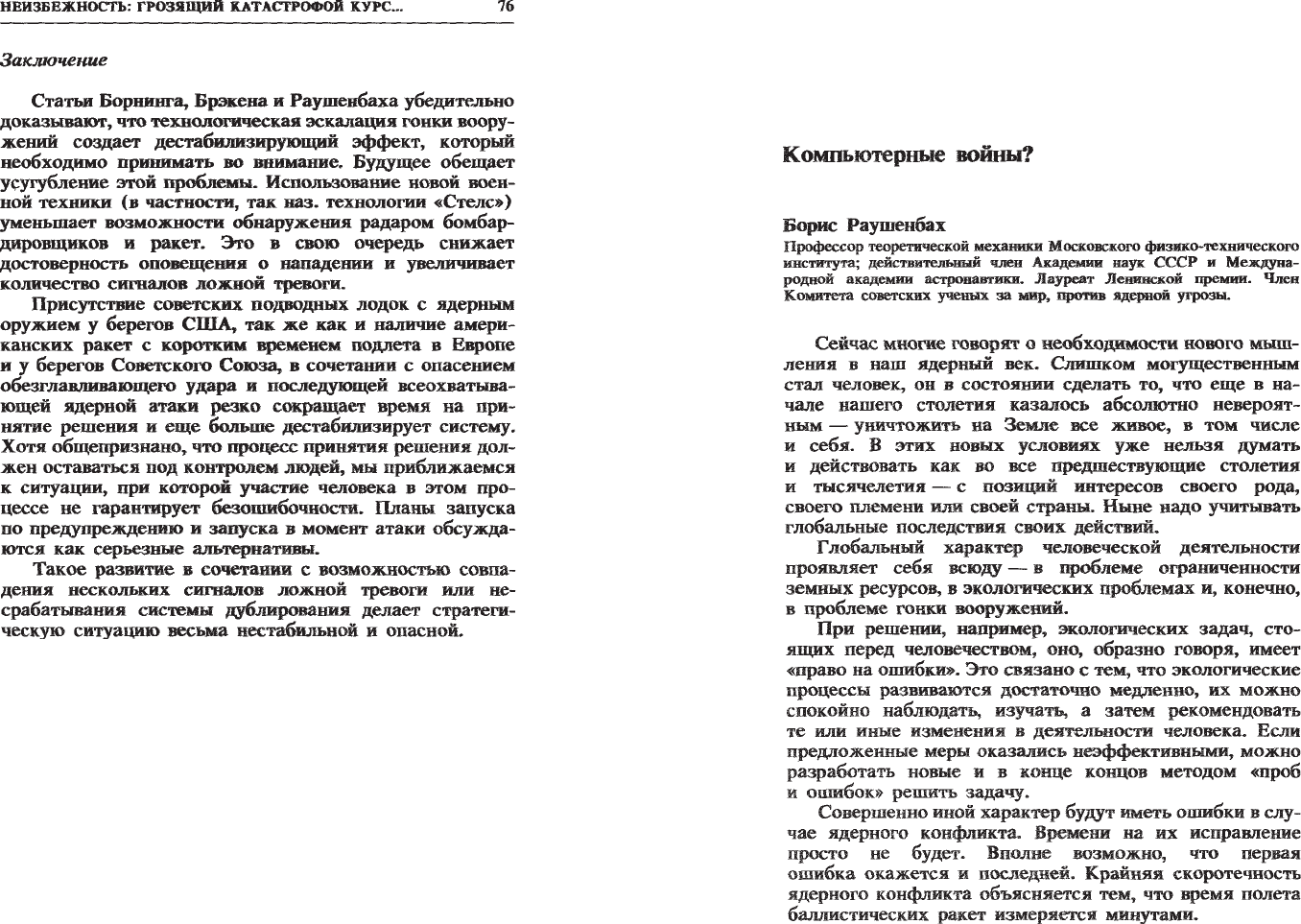

Следующая

таблица

показывает

вероятную

перио

дичность

несра6атывания

системы

дублирования,

вычис

ленную

исходя

из

упомянутого

выше

времени

разреше

ния

ложного

сигнала,

равного

3,5

мин.

т

а

6

л

и

ц

а

2.

ВepoJl'l1lIU1

пеРИОДllЧНOCТЬ

несрабатывamur

системы

дуб.вировamur

Кол-во

ложных

CIIГН8JIOB

В

ГОД

от

СnYТВИI<ов

от

радаров

Вероятная

периодичность

не

cpa6aTывRJ[Jl

снстемы

ду6лиро

рования

(годы)

5 5 6000

Ш

Ш

lD

~ ~

~

100

~

~

~

100

~

100 100 15

200 200 3,8

Заметьте,

что

удвоение

количества

ложных

сигналов

лвэбого

типа

повьnпает

ццвое

периодичность

несрабаты

ваиия

системы

дублирования,

а

удвоение

количества

ложных

сигналов

обоих

типов,

по

аналогии

с

табл.

1,

повышает

периодичность

<<подтвержденных»

ошибок

в

четыре

раза.

Вероятность

«предупредительного»

удара

Кратковременность

подлета

современных

межконти

нентальных

баллистических

ракет

(около

30

мин.)

и

еще

более

короткое

время

подлета

ракет,

запускаемых

с

под

водных

лодок,

а

также

ракет

среднего

радиуса

действия

(менее

10

мин.)

сокращает

время

предупреждения

прак

тически

до

нуля.

Одной

из

возможных

реакций

на

та

кую

угрозу

является

так

наз.

«запуск

по

предупрежде

нию»,

или

«запуск

в

момент

атаки».

Выбор

подобной

стратегии

мотивируется

страхом

перед

неожиданным

УАЩ>Ом,

который

может

оказаться

парализующим,

обез

главливающим.

«Обезглавливающий

удар»

суть

страте-

КОМПЬЮТЕРНЫЕ

СИСТЕМЫ

И

ЯДЕРНАЯ

ВОЙНА

75

гии,

при

которой

одна

сторона

из

опасения

неизбежного

нападения

на

нее

другой

стороны

наносит

упреждающий

удар

по

руководству

и

командным

центрам

противника

4.

Цель

такого

удара

-

парализовать

действия

противника,

лишить

его

возможности

нанести

удар.

Поскольку

каж

дая

сторона

четко

осознает

ВОЗМОЖНОСТЬ

обезглавливаю

щеI;О

удара

со

стороны

противника,

возникает

сильное

желание

нанести

удар

первым.

Как

отмечает

в

этой

кни

ге

Брэкен,

«никто

не

хочет

войны,

но

каждый

предпочел

бы

напасть

первым,

чтобы

не

оказаться

вторым.

Вместо

выбора

между

войной

и

миром

решение

может

выгля

деть

так:

либо

напасть

первым,

либо

нанести

ответный

удар

...

».

В

качестве

ответной

меры

против

обезглавливающего

удара

или

аналогичной

стратегии

запуска

по

предупреж

дению

предусматривается

немедленная

контратака

как

только

будет

получено

надежное

подтверждение

начала ядерного

нападения

со

стороны

противника.

Дру

гими

словами,

контрудар

наносится

прежде,

чем

вра

жеские

ракеты

достигли

цели.

При

этом

предупреждение

о

нападении

противника

исходит

от

сигналов,

получен

ных

датчиками

спутниковой

системы

и

подтвержден

ных

через

несколько

минут

радаром.

Такое

условие

является

требованием

вышеупомянутой

системы

двойной

проверки.

Существуют

различные

предположения

относительно

того,

придерживаются

ли

США

стратегии

запуска

по

предупреждению

или

запуска

в

момент

атаки.

В

недав

ней

статье

Брюса

Блейра

и

Роберта

Макнамары

5

Сое

диненным

Штатам

предлагается

немедленно

публично

отречься

от

подобных

планов.

Официальная

линия

пока

что

заключается

ни

в

подтверждении,

ни

в

отрицании

указанной

стратегии.

Тем

временем

Советский

Союз

пре

дупредил

6,

что

он

может

перейти

к

стратегии

запуска

по

предупреждению

в

ответ

на развертывание

странами

НАТО

ракет

типа

«Першинг-2»

с

кратким

временем

подлета

.

Из

табл

.

2

следует,

что

при

появлении

порядка

100

ложных

сигналов

в

год

со

спутников

и

радаров

ожидаемое

время

до

вероятного

несрабатывания

системы

дублирования,

которое

может

привести

к

встречному

запуску

по

предупреждению,

составляет

неутешительные

15

лет.

НЕИЗБЕЖНОСТЬ:

грозящий

КЛТАCI'PОФОЙ

курс

...

76

Заключение

Статьи

Борнинга,

Брэкена

и

Раушенбаха

убедитt'ЛЬНО

доказывIoт,'

что

теХНOJlоrическая

эскалация

гонки

воору

жений

создает

дестабилизирующий

эффект,

который

необходимо

принимать

во

внимание.

БУдУщее

обещает

усугубление

этой

проблемы.

Использование

новой

воен

ной

техники

(в

частности,

так

паз.

технологии

«Стелс»

)

уменьшает

возможности

обнаружения

радаром

бомбар

дировщиков

и

ракет.

это

в

свою

очередь

снижает

достоверность

оповещении

о

нападении

и

увеличивает

количество

сигналов

ложной

тревоrи.

Присутствие

советских

подводных

лодок

с

ядерным

оружием

у

берегов

США.

так

же

как

и

наличие

амери

канских

ракет

с

коротким:

временем

ПОдЛета

в

Европе

и

у

берегов

Советского

Союза,

в

сочетании

с

опасением

обезглавливающего

удара

и

последующей

всеохватыва

ющей

ядерной

атаки

резко

сокращает

время

на

при

питие

решении и

еще

больше

дестабилизирует

систему.

Хотя

общепризнано,

что

процесс

принятия

решения

дол

жен

оставаться

под

контролем

ЛlOдей,

мы

приближаемся

к

ситуации,

при

которой

участие

человека

в

этом

про

цессе

не

гарантирует

безошибочности.

ПЛаны

запуска

по

предупреждеНИIO

и

запуска

в

момент

атаки

обсу.жда

lOТCЯ

как

серьезные

альтернативы.

Такое

развитие

в

сочетании

с

возможностыо

СОвпа

дении

нескольких

сигналов

ложной

тревоги

или

не

срабатываии

системы

дУблирования

делает

стратеги

ческую

ситуацию

весьма

нестабильной

и

опасной.

Компьютерные

войны?

Борис

РаYIПенбах

Профессор

теоретической

механики

Московскоro

физико-техвическоro

института;

действительный

член

Академии

наук

ссср

и

Междуна

родной

академии

астронавтики.

Лауреат

Ленинской

иремии.

Член

Комитета

советских

ученых

за

МИР,

против

ядерной

угрозы.

Сейчас мноrие

говорят

о

необходимости

нового

мыш

ления

в

наш

ядерный

век.

Слишком

могущественным

стал

человек,

он

в

состоянии

сделать

то,

что

еще

в

на

чале

нашего

столетии

казалось

абсолютно

невероят

ным

-

уничтожить

на

Земле

все

живое,

в

том

числе

и

себя.

В

этих

новых

условиях

уже

нельзя

думать

и

действовать

как

во

все

предшествующие

столетия

и

тысячелетия

-

с

ПОЗИЦИЙ

интересов

своего

рода,

своего

племени

или

своей cтpaны.

Ньme

надо

учитывть

глобальные

последствия

своих

действий.

Глобальный

характер

человеческой

деятельности

проявляет

себя

всюдУ

-

в

проблеме

ограниченности

земных

ресурсов,

в

экологических

проблемах

и,

конечно,

в

проблеме

гонки

вооружений.

При

решении,

например,

экологических

задач,

сто

ящих

перед

человечеством,

оно,

образно

говоря,

имеет

«право на

оmиБКИ».

Это

связано

с

тем,

что

экологические

процессы

развиваются

достаточно

медленно,

их

можно

спокойно

наблюдатъ,

изучать,

а

затем

рекомендовать

те

или

иные

изменения

в

деятельности

человека.

Если

предложенные

меры

оказались

неэффективными,

можно

разработать

новые

и

в

конце

концов

методом

«проб

и

ошибок»

решить

задачу.

Совершенно

иной

характер

будУТ

иметь

ошибки

в

слу

чае

ядерного

конфликта.

Времени

на

их

исправление

просто

не

будет.

Вполне

возможно,

что

первая

ошибка

окажется

и

последней.

Крайняя

скоротечность

ядерного

конфликта

объясняется

тем,

что

время

полета

баллистических

ракет

измеряется

минутами.