Растригин Л.А. Адаптация сложных систем

Подождите немного. Документ загружается.

Поведение сглаженного значения (4.5.19) минимизируемой

функции в этих процессах поиска показано на рис. 4.5.6. Наглядно

видна сходимость процесса.

Таким образом, применение глобального случайного поиска

позволяет эффективно восстанавливать утраченные элементы

таблицы.

§ 4.6. Адаптация алгоритмов распознавания

Решение проблемы повышения эффективности распознающих

решающих правил в настоящее время затрудняется значительной

априорной неопределенностью структуры решаемой задачи

распознавания. Там, где эта структура проста, удается предложить

весьма эффективные способы синтеза распознающих решающих

правил [13, 30, 89, 90, 151]. Однако научно-техническая практика

очень часто выдвигает такие сложные задачи, относительно

структуры которых априори почти ничего нельзя сказать. Именно в

этом случае со всей остротой встает проблема выбора структуры

решающего правила. Интуиция исследователя, на которую обычно

уповают [30], здесь дает крайне мало, а зачастую и ухудшает выбор

ввиду влияния малосущественных факторов (мода, опыт

исследователя, случай и т. д.).

Действительно, успешному применению алгоритма должна

предшествовать проверка некоторых условий его применимости.

Примерами таких условий могли служить, например, гипотеза

компактности в методе потенциальных функций [13], требование

нормальности априорных распределений в статистических

алгоритмах [89, 90], условие неразличимости признаков [90] и т. д.

Проверка этих условий для сложных задач распознавания обычно

невозможна [285].

Однако при синтезе алгоритмов необходимо прежде всего

определять их структуру. Это можно сделать двояким образом. С

одной стороны, можно пытаться создать метаструктуру объектов

распознавания, обобщающую известные структуры. Примером

такой метаструктуры являются всякого рода языки описания

ситуаций, например двумерные грамматики при распознавании

плоских изображений [241]. Этот путь требует чрезвычайно

тщательного исследования и формализации рассматриваемого поля

задач, что удается далеко не всегда и лишь для весьма узкого

класса задач. Пожалуй, единственным примером такой

формализации является создание уже упомянутых двумерных

грамматик [241]. Именно поэтому для решения «сложных задач

распознавания следует изыскивать другие под-

ходы.

В качестве одного из таких подходов можно предложить

использовать структуры уже известных решающих правил. Это

означает, что искомую структуру следует искать как некую

комбинацию известных структур. Такой путь в сочетании с

адаптацией оказался весьма плодотворным и получил название

коллективного (по аналогии принятия коллективных экспертных

решений). Рассмотрим его [177].

Пусть имеется L различных алгоритмов распознавания R

i

(i = 1, ...,

L), каждый из которых имеет следующую структуру:

R

i

: S

i

=R

i

(X) = sgn f

i

(X), (4.6.1)

где — решение, принимаемое i-м алгоритмом в си-

туации X, а

(4.6.2)

(для простоты рассматриваем случай дихотомии). Тогда кол-

лективное решающее правило можно представить в виде

R : S = F (R

1

(X), ..., R

L

(X) ), (4.6.3)

где функция F реализует свертку индивидуальных решений в

коллективное. Приведем очевидные примеры синтеза функции F.

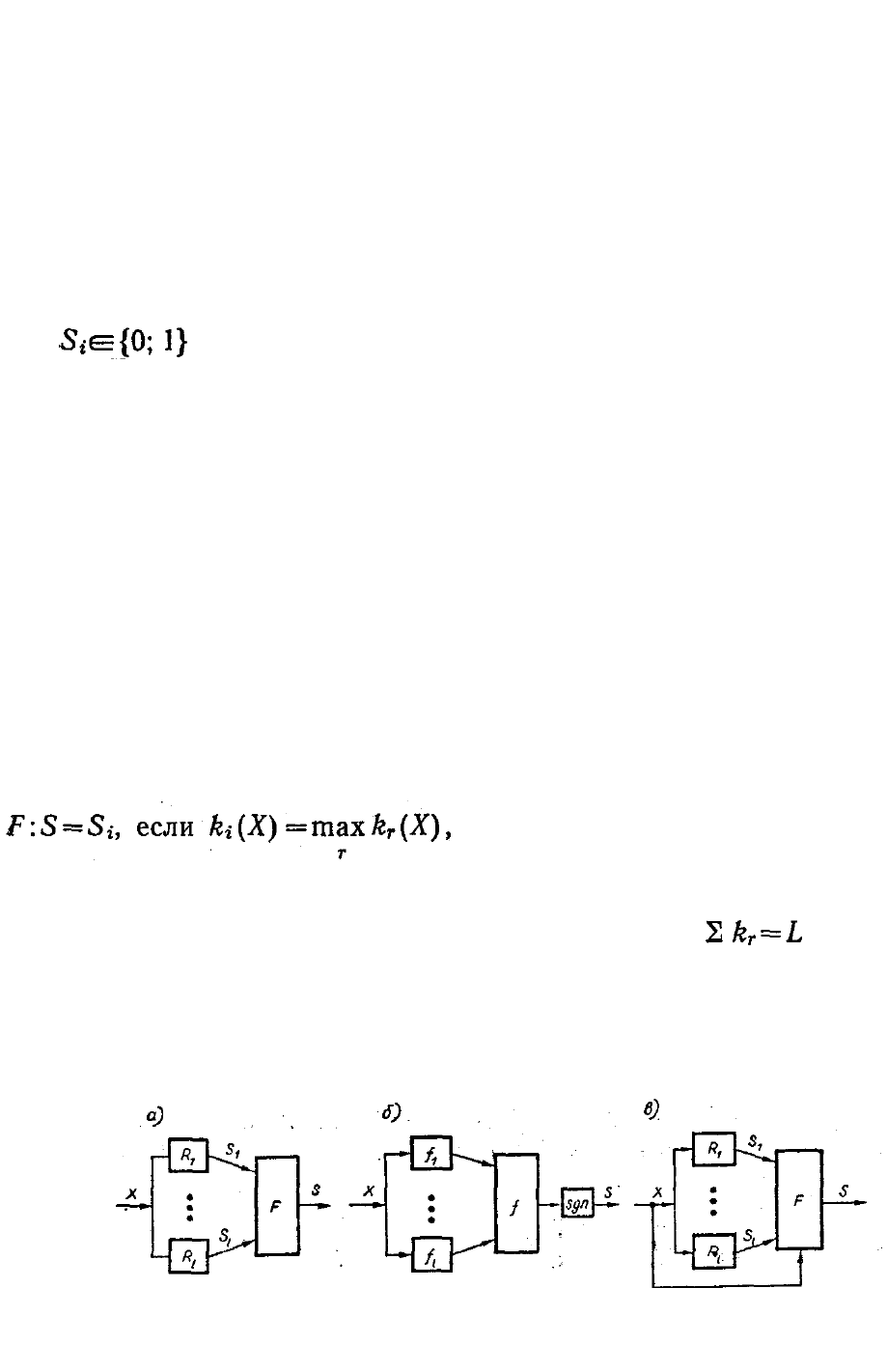

Простейшим способом организации коллективного решения

является равноправное голосование членов коллектива (рис.

4.6.1, а). Это означает, что принимается решение, собирающее

большинство голосов, т. е.

(4.6.4)

где k

r

(X) — число голосов,

набранное r-м решением S

r

в ситуации X. При этом , т. е.

членам коллектива запрещается голосовать одновременно за два

решения. Существует немало известных методов распознавания,

которые работают

Рис. 4.6.1. Блок-схемы коллективных решений: а — голосование, б

— гибрид, в — коллектив решающих правил.

по указанной схеме принятия коллективного решения. Примерами

таких методов являются алгоритмы статистических решений [45],

некоторые локальные методы [239], корреляционные методы [230] и т.

д.

Такой подход можно улучшить, введя понятие взвешенного

голосования. В этом случае решения каждого из членов коллектива

взвешиваются и голосование производится с весами. Для этого

достаточно в формуле (4.6.4) определить k

τ

(X) = = , где υ

l

>0 — вес

решающего правила R

l

, a Ω

τ

— множество правил, голосовавших за r-е

решение. Вес υ

l

может быть определен, например, как величина,

обратная оценке ошибочности правила R

l

. Примерами использования

такого взвешенного голосования являются известные перцептронные

алгоритмы [64].

Гибридное решающее правило [79] является обобщением

описанных алгоритмов голосования. Оно реализуется с помощью

скалярной функции свертки f, которая определяется не на множестве

решений исходных решающих правил {S

1

,...,S

L

}, а на значениях {f

1

, ...,

f

L

} (см, рис. 4.6.1, б):

R : S = sgn f ( f

1

(X), ..., f

L

(X) ), (4.6.5)

где функция f, определяющая гибрид, задается в виде пары f = ‹ β, α ›.

Здесь β — вид свертки (ее структура), а α = (α

1

, ..., α

k

) — вектор

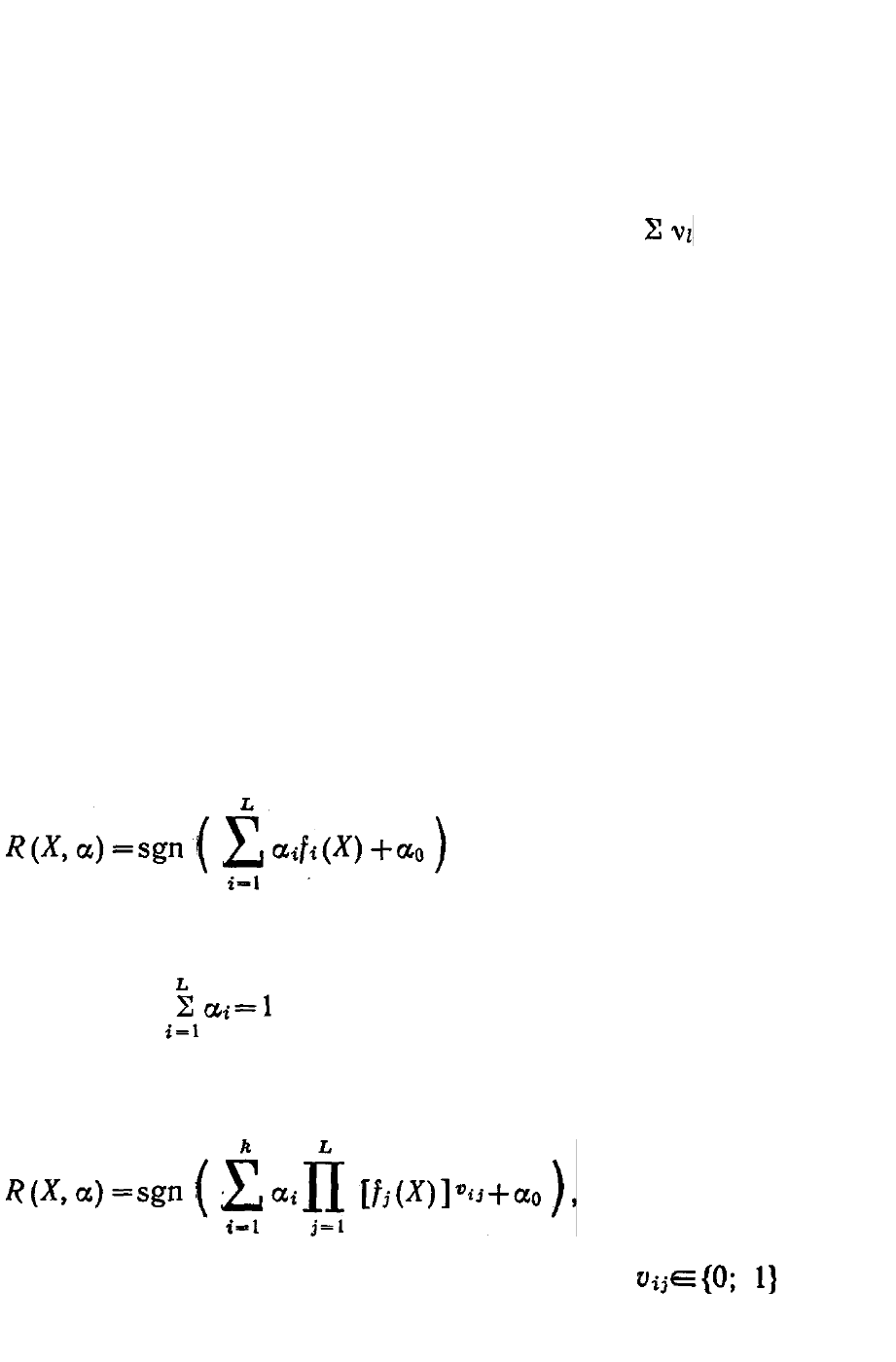

параметров этой свертки. Например, в случае линейной свертки

гибридное решающее правило имеет вид

(4.6.6)

при естественном нормирующем

ограничении . В нели-

нейном случае F может быть представлена любой полиномиальной

функцией L переменных:

(4.6.7)

где , a k —

число слагаемых. Выбор параметров α

гибридных правил производится путем минимизации ошибок

распознавания на обучающей выборке, т. е. решением оптими-

зационной задачи

(4.6.8)

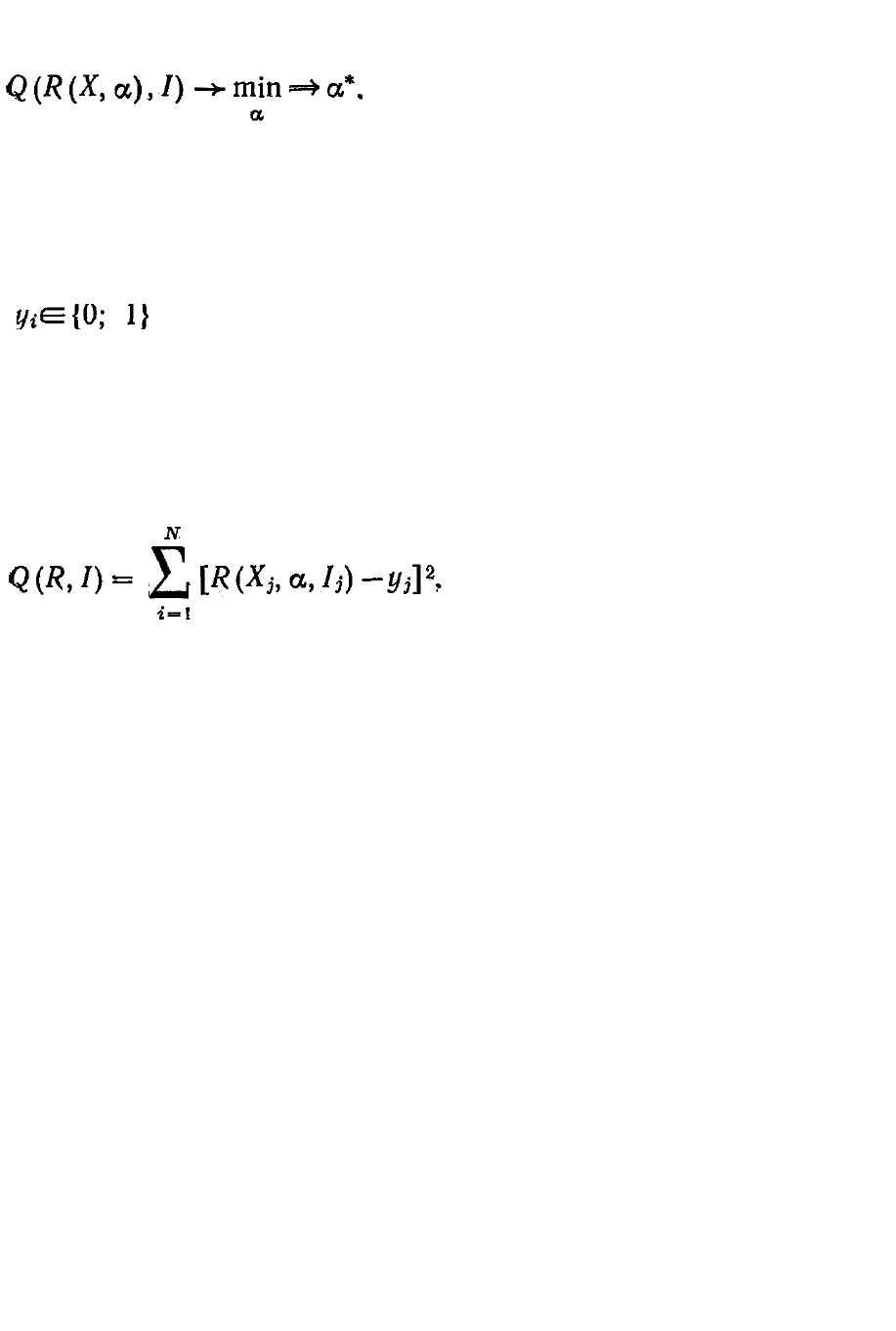

Здесь Q(R,I) — функционал

эффективности решающего правила R на обучающей выборке I:

l = ‹ X

i

, y

i

› (i = 1, ..., N), (4.6.9)

где Х

i

— i-я ситуация выборки, а y

i

— ее принадлежность к классу

( ). Функционал Q в простейшем случае мо-

жет быть определен, например, как число ошибок правила R на

обучающей выборке I. Однако наиболее интересна экстраполирующая

способность правила R, которая определяется в виде числа ошибок

правила, обученного на различных вариантах N—1 точки выборки

[100], при проверке правила на оставшейся точке (метод скользящего

контроля):

(4.6.10)

где R(X

j

, α, I

j

) — правило,

обученное на выборке I

j

, полученной из / усечением ее

на один j-й элемент:

I

j

= ‹ X

i

, y

i

› (i = 1, ..., j-1; j+1, ... , N). (4.6.11)

Для решения задачи (4.6.8) используются различные алгоритмы

случайного поиска [166]. В случае большого числа k параметров

оптимизация гибридного решающего правила осуществляется

путем структурной оптимизации. Она реализуется

последовательным добавлением к гибриду из L—1 правил нового L-гo

решающего правилами оптимизацией только тех параметров, которые

связаны с решением L-гo правила. Этим процесс оптимизации

значительно упрощается, так как число оптимизируемых

переменных резко сокращается. Так, для линейной свертки (4.6.6)

при добавлении одного правила в свертку решение задачи

оптимизации производится трлько по одному параметру (и лишь

на первом шаге, когда L = l, имеем двухпараметрическую

оптимизацию по α

0

и α

1

).

Легко видеть, что гибридное решающее правило (4.6.3), по-

лученное путем оптимизации (4.6.8), обладает очевидным свойством:

оно не может быть хуже лучшего из решающих правил,

входящих в этот гибрид. Практически же оно всегда оказыва-

ется значительно лучше.

Указанное свойство гибридного решающего правила проил-

люстрировано на нескольких примерах [79]. В одном из них

гибрид был образован линейной сверткой (4.6.6) двух алгоритмов

Фикса—Ходжеса с различными радиусами сфер сбора информации:

f(X) = α f

1

(X) + (1 — α) f

2

(X). В результате оптимизации по параметру

свертки а получена минимальная вероятность ошибки распознавания

гибридом: Р

min

=0,29 (при α

*

= = — 1,2), тогда как вероятности ошибки

распознавания каждого алгоритма в отдельности были: P

1

= 0,43 (при

α=1) и Р

2

=0,36 (при α = 0).

Аналогичный результат был получен при эксперименте на

гибридном решающем правиле, которое было образовано линейной

сверткой трех алгоритмов распознавания: Фикса—Ходжеса,

потенциальной функции и линейной дискриминантной функции: f(X)

= α

1

f

1

(X) + α

2

f

2

(X) + (1 — α

1

— α

2

) f

3

(X). После оптимизации по

параметрам свертки α

1

и α

2

глобальным алгоритмом случайного

поиска вероятность ошибки распознавания гибридного решающего

правила была Р

min

=0,35, а вероятности ошибки распознавания каждого

из алгоритмов, свернутых в гибрид, составляли соответственно: P

1

=

0,49 (при α

1

= l, α

2

= = 0); Р

2

= 0,43 (при α

1

=0, α

2

=l) и Р

3

= 0,54 (при

α

1

=α

2

=0).

Нелинейная свертка (4.6.7) двух алгоритмов распознавания

Фикса—Ходжеса с разными параметрами: f(X) = α

1

f

1

(X) + + α

2

f

2

(X) +

(l — α

1

— α

2

) f

1

(X) f

2

(X) дала вероятность ошибки распознавания

оптимального гибрида P

min

=0,24, тогда как каждый алгоритм в

отдельности распознавал обучающую выборку со значительными

ошибками: P

1

= 0,43 (при α

1

=l, α

2

=0) и Р

2

= = 0,46 (при α

1

=0, α

2

=l).

Отсюда следует, что гибрид всегда лучше, нежели лучшее из

входящих в него правил, благодаря обязательному введению

процедуры оптимизации параметров гибрида.

Таким образом, синтез оптимальных гибридных решающих правил

распознавания дает возможность получить правила, свойства которых

превышают свойства исходных правил, входящих в гибрид.

Процедура синтеза гибрида заключается в выборе исходных правил R

i

(i = l, ..., L) и минимизации критерия качества гибрида Q по

параметрам свертки функции F, т. е. в решении задачи (4.6.8).

Однако гибрид обладает одним недостатком — неявной за-

висимостью решения от ситуации X. Это обстоятельство сужает

возможности гибридных алгоритмов, хотя и упрощает их синтез.

Рассмотрим теперь решающие правила с явной зависимостью

решения от ситуации X. В отличие от (4.6.5) они имеют вид (см. рис.

4.6.1, в):

S = F ( R

1

(X), R

2

(X), ..., R

L

(X), X). (4.6.12)

Здесь функция F имеет L + п аргументов (n = dim X), и поэтому

ее синтез значительно труднее, чем (4.6.5). Однако и возможностей

при этом больше.

Хорошие результаты при реализации (4.6.12) показала следующая

эвристика, названная коллективом решающих правил [189—191]. Веса

голосующих правил не детерминированы, а изменяются от ситуации к

ситуации. Для этого все пространство ситуаций условно разбивается

на области предпочтительности применения того или иного

решающего правила и вводится зависимость веса l-го решающего

правила от ситуации X в виде υ

l

=υ

l

(X). Весовые коэффициенты

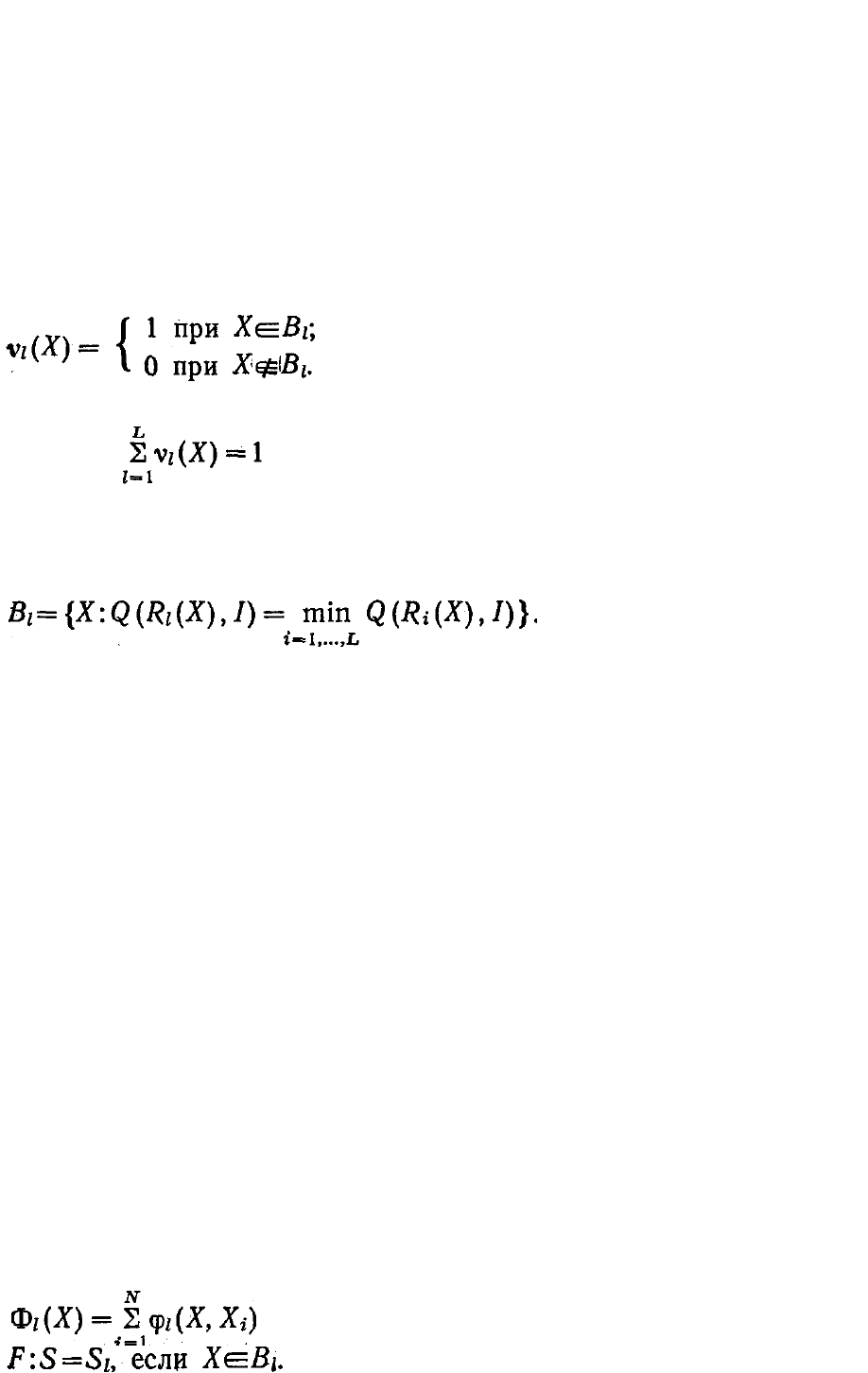

определяются следующим образом:

Здесь , a B

l

— область компетентности l-го ре-

шающего правила, которая определяется как область ситуаций {X},

где данное решающее правило имеет наилучшее качество по

заданному критерию Q, т. е.

(4.6.14)

Это означает, что

решение коллектива в ситуации X определяется решением такого

правила R

l

, к области компетентности которого (B

l

) эта ситуация

принадлежит, т. е. S=S

l

.

Как видно, предлагаемый подход представляет собой двух-

уровневую процедуру распознавания: на первом уровне осу-

ществляется распознавание принадлежности ситуации X к той или

иной области компетентности B

l

(l=1,...,L), на втором — решение

выделенного таким образом правила отождествляется с решением

всего коллектива, т. е.

(4.6.15)

При подобной организации коллективного решения основной

задачей является синтез алгоритма определения областей ком-

петентности B

l

(l=1, ..., L) решающих правил, входящих в коллектив.

Естественно для членения пространства признаков на области

компетентности воспользоваться методами распознавания — здесь

решается L-классовая задача.

Один из алгоритмов синтеза коллектива основан на методе

потенциальных функций, и его можно назвать алгоритмом вос-

становления потенциалов компетентности. Суммарный потенциал

' определяет потенциал компетентности

l-го решающего правила, наводимый точками обучающей по-

следовательности в произвольной точке X. Решение в точке X

принимает правило с номером l

*

, который определяется исходя из

условия

(4.6.16)

Вообще говоря, правилом выбора

алгоритма может стать любое, легко решающее многоклассовую

задачу, — например, правило Байеса, ближайшей точки, Фикса—

Ходжеса и т. д. Каждое из этих правил может быть успешно

использовано для определения областей компетентности при

распознавании методом коллектива.

Надо отметить, что в результате выделения областей ком-

петентности в коллективе наряду с компетентными правилами (у

которых области компетентности велики) могут оказаться как

малокомпетентные, так и некомпетентные решающие правила

(область компетентности мала или вообще отсутствует). Естественно

поставить задачу синтеза коллектива решающих правил,

образованного компетентными правилами.

Существует немало методов поиска оптимального коллектива

алгоритмов распознавания. Одним из них является алгоритм селекции,

рассмотренный в работе [189], согласно которому вводятся критерии

эффективности решающих правил:

1. Средний вклад l-го решающего правила, т. е. доля объек

тов, распознаваемых этим правилом как наиболее компетент

ным:

a

l

= n

l

/ N, (4.6.17)

где n

l

— число объектов контрольной последовательности, для

которых l-е правило наиболее компетентно; N — объем этой

последовательности.

2. Вероятность правильного распознавания l-м правилом при

условии, что оно является наиболее компетентным:

p

l

= m

l

/ n

l

. (4.6.18)

Тогда задача селекции, т. е. задача синтеза оптимального

коллектива правил, формируется как многокритериальная задача с 2L

критериями:

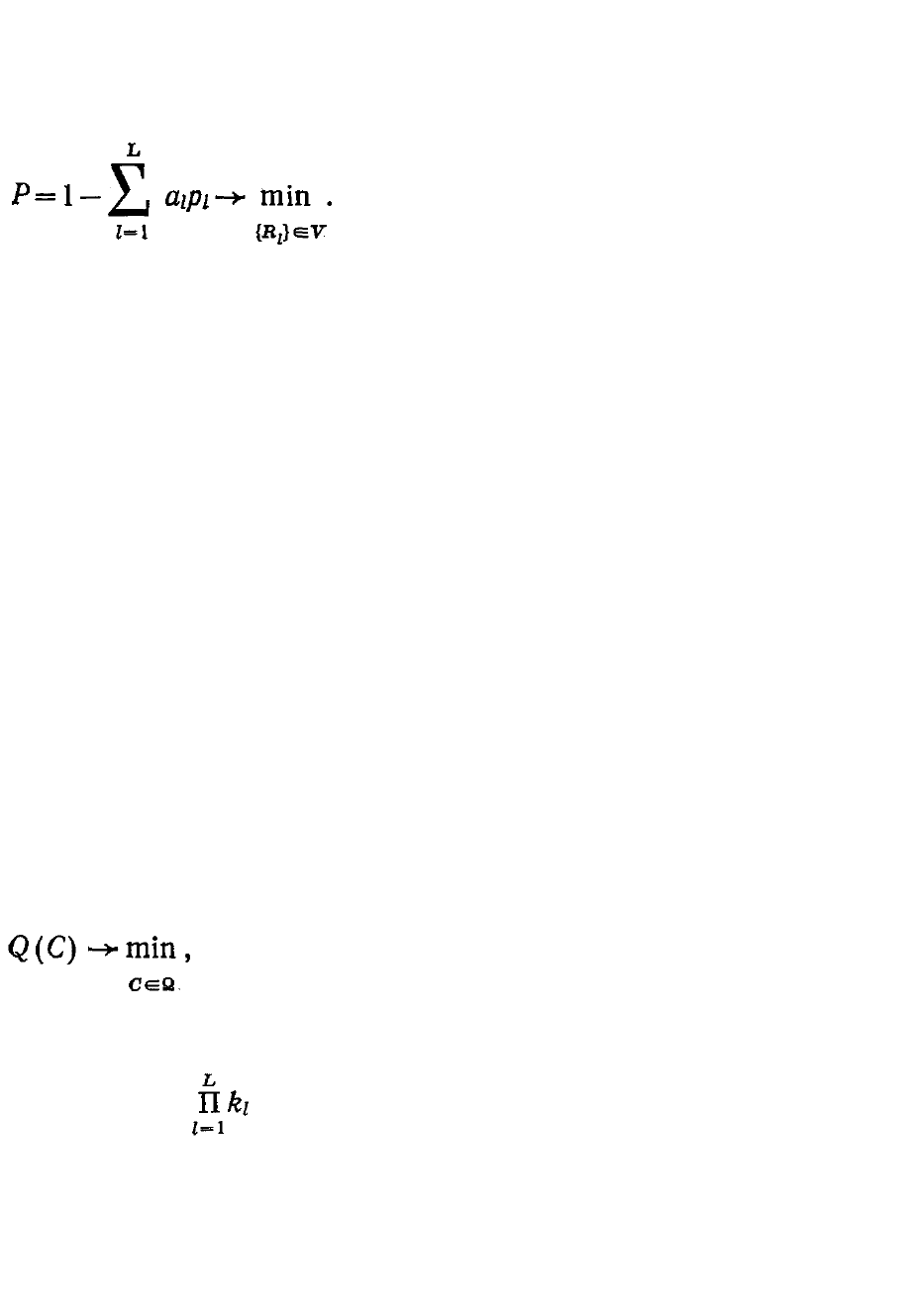

(4.6.19)

где V — множество допустимых решающих правил, генерируемых для

селекции. Поставленная многокритериальная задача

может быть сведена к однокритериальной путем введения обоб-

щенного критерия вероятности ошибки распознавания коллективом,

которую, естественно, нужно минимизировать в процессе синтеза

коллектива:

(4.6.20)

Указанный критерий оптимизируется путем

применения эвристического алгоритма селекции. С помощью этого

алгоритма генерирование новых членов и замена малокомпетентных и

некомпетентных решающих правил новыми членами улучшает ка-

чество работы коллектива. Очевидно, что указанные в работе [189]

алгоритмы селекции не исчерпывают все возможности выбора

разумных приемов для достижения указанных целей. Другим методом

синтеза оптимального коллектива алгоритмов распознавания является

оптимизация параметров решающих правил — членов коллектива — с

помощью алгоритмов поиска [190]. Здесь рассматривается коллектив

алгоритмов, где каждое решающее правило задается с точностью до

конечного числа параметров. Тогда, очевидно, свойства коллектива

решающих правил определяются параметрами решающих правил,

составляющих коллектив. В пространстве этих параметров, которое

естественно называть пространством коллективов, каждый

конкретный коллектив отображается в точку. Для оптимизации такого

коллектива алгоритмов можно воспользоваться адаптивным

глобальным алгоритмом случайного поиска [166] параметров

решающих правил этого коллектива. Обозначив

через C

l

= (c

1

(l)

, ..., c

kl

(l)

) — вектор параметров l-го решающего

правила R

l

, задачу синтеза оптимального коллектива можно записать в

виде

(4.6.21)

где Q — критерий эффективности коллектива,

например, по (4.6.10); С = (C

1

,...,C

l

) — вектор параметров коллектива

размерностью , а Ω — область определения этих параметров.

Очевидно, что использование предложенного параметрического

метода оптимизации коллектива эффективно лишь при малых k

l

и L.

Для решения этой задачи при большом числе параметров можно

предложить прием структурной адаптации [78]. Его суть заключается

в последовательном наращивании коллектива новыми членами —

алгоритмами распознавания. Сначала коллек-

тив состоит из одного решающего правила R

1

и задача оптимизации

(4.6.21) решается только по параметрам C

1

этого правила. Далее

образуется коллектив из двух правил путем добавления второго

решающего правила R

2

с неизвестными параметрами C

2

, которые

определяются путем оптимизации коллектива решающих правил по

параметрам C

2

. Эта процедура продолжается до тех пор, пока

вероятность ошибки распознавания коллективом алгоритмов не станет

достаточно малой. Как видно, здесь на каждом этапе производится

оптимизация по параметрам C

i

лишь одного решающего правила R

i

,

что значительно упрощает задачу оптимизации.

Эффективность предложенного способа структурной оптимизации,

т. е. метода последовательного наращивания коллектива новыми

членами, показана на модельной задаче [78]. В коллектив были

объединены линейные дискриминантные функции, т. е. каждое из

решающих правил задавалось n+1 параметром линейной формы.

Добавление членов коллектива осуществлялось до выполнения

критерия останова P≤0,02. Во всех десяти экспериментах этот

критерий достигался коллективом, составленным из L = 3—5

алгоритмов при n=2. Для сравнения рассматривался случай

наращивания коллектива случайными линейными правилами без

оптимизации. В результате десятикратного эксперимента указанный

критерий останова достигался, когда в коллектив были объединены в

среднем одиннадцать линейных решающих правил. В другом примере

на той же модельной задаче проводилась одновременная оптимизация

параметров всех членов коллектива (т. е. решалась задача (4.6.21)).

Значения критерия Р≤0,02 не удалось достигнуть ни в одном

эксперименте.

Приведенные результаты экспериментов указывают на пре-

имущество метода последовательной оптимизации по сравнению с

одновременной оптимизацией всех параметров коллектива или

случайной генерацией новых членов коллектива без оптимизации.

Очевидно, что в коллектив кроме параметрических решающих

правил могут быть объединены и непараметрические решающие

правила, к которым относятся, например, алгоритм Байеса, «Кора» и

др. Специфика работы с такими алгоритмами заключается в том, что

ввиду отсутствия параметров они не могут быть оптимизированы

параметрически. С другой стороны, параметры параметрических

алгоритмов не всегда позволяют варьировать свойства этих

алгоритмов в необходимых пределах. Эти обстоятельства заставляют

искать новые пути создания оптимального разнообразия в коллективе

таких алгоритмов. Для преодоления указанной трудности предлагается

варьировать обучающую выборку [80]. Например, эту вариацию

можно

осуществить путем стохастического изменения принадлежности

объектов к заданным классам или путем случайного изменения

координат объектов обучающей выборки в пространстве признаков. В

первом случае элементы обучающей выборки случайно заменяются

другими элементами того же множества. Такие преобразования

характеризуются стохастической матрицей:

P = || p

ij

||

l×l

, . (4.6.22)

где / — число классов, а p

ij

— вероятность изменения принадлежности

элемента к i-му классу на принадлежность к j-му. Во втором случае

производится случайное варьирование координат обучающей выборки

в пространстве признаков. Затем стандартным методом обучения

определяется решающее правило R

i

. Очевидно, что каждое

варьирование обучающей выборки позволяет получить новый

алгоритм распознавания, что необходимо при организации коллектива

алгоритмов.

Надо отметить, что после применения того или иного метода

оптимизации полученный коллектив должен обладать некоторым

разнообразием, т. е. правила, составляющие коллектив, должны быть

достаточно разнообразны по своей структуре. С другой стороны,

слишком большое разнообразие снижает эффективность

распознавания. Поэтому естественно рассмотреть задачу синтеза

коллективных и гибридных решающих правил с оптимальным

разнообразием исходного множества решающих правил [81].

Для параметрических алгоритмов распознавания каждый член

исходного множества решающих правил в пространстве признаков

отображается в точку, а сам коллектив и гибрид — в совокупность

таких точек. В этом случае разнообразие вводится в виде среднего

значения расстояния между этими точками [189]. Для коллектива и

гибрида непараметрических алгоритмов распознавания такой подход

непригоден из-за отсутствия параметров. Поэтому для них [80]

вводится другая мера разнообразия — коэффициент варьирования

обучающей выборки (например, среднеквадратичное отклонение).

Показано [80], что такое варьирование обучающей выборки позволяет

получить разнообразие как коллектива, так и гибридов непара-

метрических решающих правил, а оптимизацией этого параметра

варьирования можно получить коллектив и гибрид с оптимальным

разнообразием алгоритмов, который минимизирует вероятность

ошибки распознавания с минимальным числом членов коллектива.

В заключение отметим, что синтезированный указанным образом

коллектив является весьма мощным средством распознавания

ситуаций. Все перечисленные свойства коллектива и