Лекции по теории передачи информации

Подождите немного. Документ загружается.

Значение Р

1

находится в пределах

,10

1

<

<

P

следовательно,

1

logPI

−

=

всегда положительная величина.

Количество информации

P

I

log

−

=

, где Р – вероятность события, было

положено в основу и было исходной точкой создания теории информации.

1.2. Энтропия ансамбля

Ансамблем называется полная совокупность состояний с вероятностями их

появлений, составляющими в сумме единицу:

,

21

21

⎟

⎟

⎠

⎞

⎜

⎜

⎝

⎛

=

kj

kj

PPPP

XXXX

X

LL

LL

(1.9)

причем

.1

1

=

∑

=

k

i

i

P

Пусть имеет место N возможных исходов опыта, из них k разных, и i-й ис-

ход (i = 1, 2,..., k) повторяется n

i

раз и вносит информацию, количество которой

оценивается как I

i

. Тогда средняя информация, доставляемая одним опытом,

равна

.

2211

N

InInIn

I

kk

ÑÐ

+

+

+

=

L

(1.10)

Но количество информации в каждом исходе согласно (1.8) будет

.log

1

PI

i

−

=

(1.11)

Тогда

.

)log()log()log(

2211

N

PnPnPn

I

kk

ÑÐ

−

+

+

−

+

−

=

L

(1.12)

Но отношение

N

n

i

представляют собой частоты повторения исходов, а

следовательно, могут быть заменены их вероятностями:

i

P

N

n

i

=

. (1.13)

Подставляя (1.13) в (1.12), получим

11

.log)log()log()log(

1

2211

∑

=

−=−++−+−=

k

i

iikkÑÐ

PPPPPPPPI L

Полученную величину К.

Шеннон назвал энтропией и обозначил буквой Н,

бит:

∑

=

−==

k

i

P

i

P

i

I

cp

H

1

log

. (1.14)

Энтропия Н представляет собой логарифмическую меру беспорядочности

состояния источника сообщений и характеризует степень неопределенности со-

стояния этого источника. Получение информации – это процесс раскрытия не-

определенности.

В информационных системах неопределенность снижается за счёт приня-

той информации, поэтому численно энтропия Н равна среднему количеству

информации, несомой произвольным исходом x

i

, т.е. является количественной

мерой информации.

Если все k различных состояний источника равновероятны, то

k

P

i

1

=

,

энтропия максимальна и из (1.14) имеем

k

k

k

i

k

H

log

1

log

1

1

max

=

∑

=

−=

. (1.15)

Нетрудно заметить, что в частном случае при равновероятных сообщениях

формулы (1.14) и (1.5) совпадают. Совпадение оценок количества информации

по Шеннону и Хартли свидетельствуют о полном использовании информаци-

онной емкости системы. В случае неравных вероятностей количество информа-

ции по Шеннону меньше информационной емкости системы.

1.3. Энтропия объединения

Объединением называется совокупность двух и более взаимозависимых

ансамблей дискретных случайных переменных.

Рассмотрим объединение, состоящее из двух ансамблей X и Y, например из

двух дискретных измеряемых величин, связанных между собой вероятностны-

ми зависимостями. Объединение ансамблей характеризуется матрицей P(X,Y)

вероятностей P(x

i

, y

i

) всех возможных комбинаций состояний

)1( nix

i

≤

≤

ан-

самбля X и состояний

ансамбля Y:

)1( miy

i

≤≤

12

),(),(),(

),(),(),(

),(),(),(

),(

1

1

1111

mnmim

jnjij

ni

yxPyxPyxP

yxPyxPyxP

yxPyxPyxP

YXP

LL

LLLLL

LL

LLLLL

LL

=

. (1.16)

Cуммируя столбцы и строки матрицы (1.16), получим информацию об ан-

самблях X и Y исходных источников:

,

)()()(

,

)()()(

1

1

1

1

mj

mj

ni

ni

yPyPyP

yyy

Y

xPxPxP

xxx

X

LL

LL

LL

LL

==

(1.17)

где

и

),()(

1

j

m

j

ii

yxPxP

∑

=

=

),()(

1

j

n

i

ij

yxPyP

∑

=

=

Вероятности P(x

i

,

y

j

) совместной реализации взаимозависимых состояний x

i

и y

i

можно выразить через условные вероятности P(x

i

/y

j

) или P(y

j

/x

i

) в соответ-

ствии с тем, какие состояния принять за причину, а какие – за следствие.

),/()()/()(),(

jijijiji

yxPyPxyPxPyxP

=

=

(1.18)

где

– вероятность реализации состояний x

)/(

ji

yxP

i

ансамбля X при условии,

что реализовалось состояние y

j

ансамбля Y; – вероятность реализации

состояний y

)/(

ij

xyP

j

ансамбля Y при условии, что реализовалось состояние x

i

ансамбля

X.

Тогда выражение для энтропии объединения в соответствии с (1.14) при-

нимает вид:

∑∑∑

∑∑

∑∑

===

==

==

−−=

=−=

=−=

n

i

n

i

ij

m

j

ijiii

iji

n

i

m

j

iji

ji

n

i

m

j

ji

xyPxyPxPxPxP

xyPxPxyPxP

yxPyxPYXH

111

11

11

,)/(log)/()()(log)(

)/()(log)/()(

),(log),(),(

(1.19)

13

где ) – случайная величина, характеризующая неоп-

ределенность, приходящуюся на одно состояние ансамбля Y при условии, что

реализовалось конкретное состояние x

/(log)/(

1

ij

m

j

ij

xyPxyP

∑

=

−

i

ансамбля X . Назовем её частной услов-

ной энтропией ансамбля Y и обозначим H(Y/x

i

):

)./(log)/()/(

1

ij

m

j

iji

xyPxyPxYH

∑

=

−= (1.20)

При усреднении по всем состояниям ансамбля X получаем среднюю неоп-

ределенность, приходящуюся на одно состояние ансамбля Y при известных со-

стояниях ансамбля X:

∑∑

∑

==

=

−=

=−=

n

i

ijij

m

j

ii

i

n

i

i

xyPxyPxPxP

xYHxPXYH

11

1

)./(log)/()()(

)/()()/(

(1.21)

Величину H(Y/X) называют полной условной или просто условной энтро-

пией ансамбля Y по отношению к ансамблю X.

Подставляя (1.21) в (1.19), получаем

).

/

()(),( X

Y

H

X

H

Y

X

H

+

=

(1.22)

Выражая

через другую условную вероятность в соответствии с

(1.18), найдем

),(

ji

yxP

),

/

()(),(

Y

X

H

Y

H

Y

X

H

+

=

(1.23)

где

)/()()/(

1

j

m

j

j

yXHyPYXH

∑

=

= (1.24)

и

(1.25)

)./(log)/()/(

1

ji

n

i

jij

yxPyxPyXH

∑

=

−=

Таким образом, энтропия объединения двух статистически связанных ан-

самблей X и Y равна безусловной энтропии одного ансамбля плюс условная эн-

тропия другого относительно первого.

В случае статистической независимости ансамблей X и Y имеют

).()(),(

jiji

yPxPyxP

=

Тогда

14

∑∑∑∑

∑∑

====

==

−−=

=−=

n

i

n

i

ij

m

j

j

m

j

jii

ji

n

i

m

j

ji

xPyPyPyPxPxP

yPxPyPxPYXH

1111

11

.)()(log)()()(log)(

)()(log)()(),(

Учитывая, что

1)(

1

=

∑

=

m

j

j

yP и ,

1)(

1

=

∑

=

n

i

i

xP

получим

).,()()(),( X

Y

H

Y

H

X

H

Y

X

H

=

+

=

(1.26)

1.4. Свойства энтропии

1.4.1. Энтропия всегда неотрицательна, так как значения вероятностей вы-

ражаются дробными величинами, а их логарифмы – отрицательными величи-

нами (1.14).

1.4.2.

Энтропия равна нулю в том крайнем случае, когда одно событие

равно единице, а все остальные – нулю. Это положение соответствует случаю,

когда состояние источника полностью определено.

1.4.3. Энтропия имеет наибольшее значение при условии, когда все веро-

ятности равны между собой (1.15).

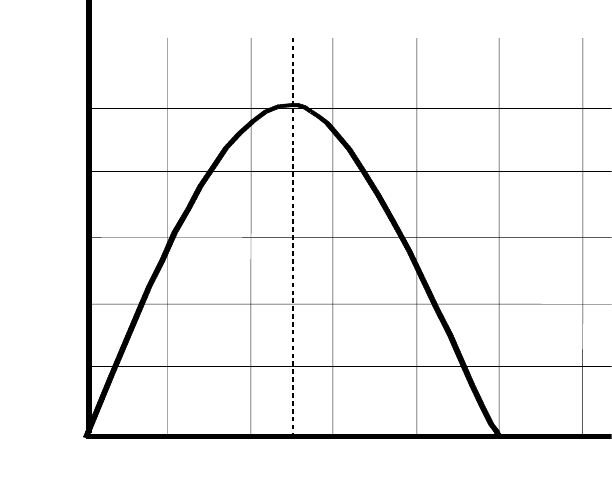

1.4.4. Энтропия источника Х с двумя состояниями х

1

и х

2

изменяется от ну-

ля до единицы, достигая максимума при равенстве их вероятностей

Р(х

1

) = Р = Р(х

2

) = 1 - Р = 0,5.

График зависимости Н(Х) в функции Р:

Н(Х) =-[PlogP + (1-P)log(1-P)], (1.27)

приведен на рис. 1.1.

Отметим, что энтропия непрерывно зависит от вероятности отдельных со-

стояний, что непосредственно вытекает из непрерывности функции -PlogP.

1.4.5. Энтропия объединения нескольких статистически независимых ис-

точников информации равна сумме энтропий

исходных источников

H(X,Y,Z,..., W) = H(X) + H(Y) + H(Z) + ... + H(W). (1.28)

1.4.6. Энтропия объединения двух статистически связанных ансамблей X и

Y равна

15

).,()(),( X

Y

H

X

H

Y

X

H

+

=

1.4.7. Энтропия объединения любого числа зависимых ансамблей опреде-

ляется из выражения

...).,,

/

(...),

/

()

/

()(),...,,,(

Z

Y

XW

H

Y

X

Z

H

X

Y

H

X

H

W

Z

Y

X

H

+

+

+

+

=

(1.29)

0,2

0,4

0,6

0,8

0,2

0,4

0,6

0,8

1,0

1,0

0,5

Н

, дв.ед.

P

Рис. 1.1. Зависимость Н(Х) в функции Р

1.4.8. Энтропия не зависит от значений, принимаемых случайными вели-

чинами, а зависит только от вероятностей их появления (1.14).

1.4.9. Если события x

i

и y

j

статистически независимы при любых i и j, то

H(Y/X) = H(Y) и H(X/Y) = H(X). (1.30)

Таким образом, сведения о результатах выбора состояний из одного ан-

самбля не снижает неопределенности выбора состояний из другого ансамбля.

Если имеет место однозначная связь в реализациях состояний

)1( nix

i

≤

≤

из

ансамбля X и

)1( njy

j

≤

≤

из ансамбля Y, то условная энтропия любого из ан-

самблей равна нулю:

H(Y/X) = 0, H(X/Y) = 0. (1.31)

Действительно, условные вероятности P(x

i

/y

j

) и P(y

j

,

x

i

) в этом случае при-

нимают значения, равные нулю или единице. Поэтому все слагаемые, входящие

в выражения (1.20) и (1.25), для частных условных энтропий равны нулю. Тогда

в соответствии с (1.21) и (1.24) условные энтропии равны нулю.

16

Равенства (1.31) отражают факт отсутствия дополнительной неопределен-

ности при выборе событий из второго ансамбля.

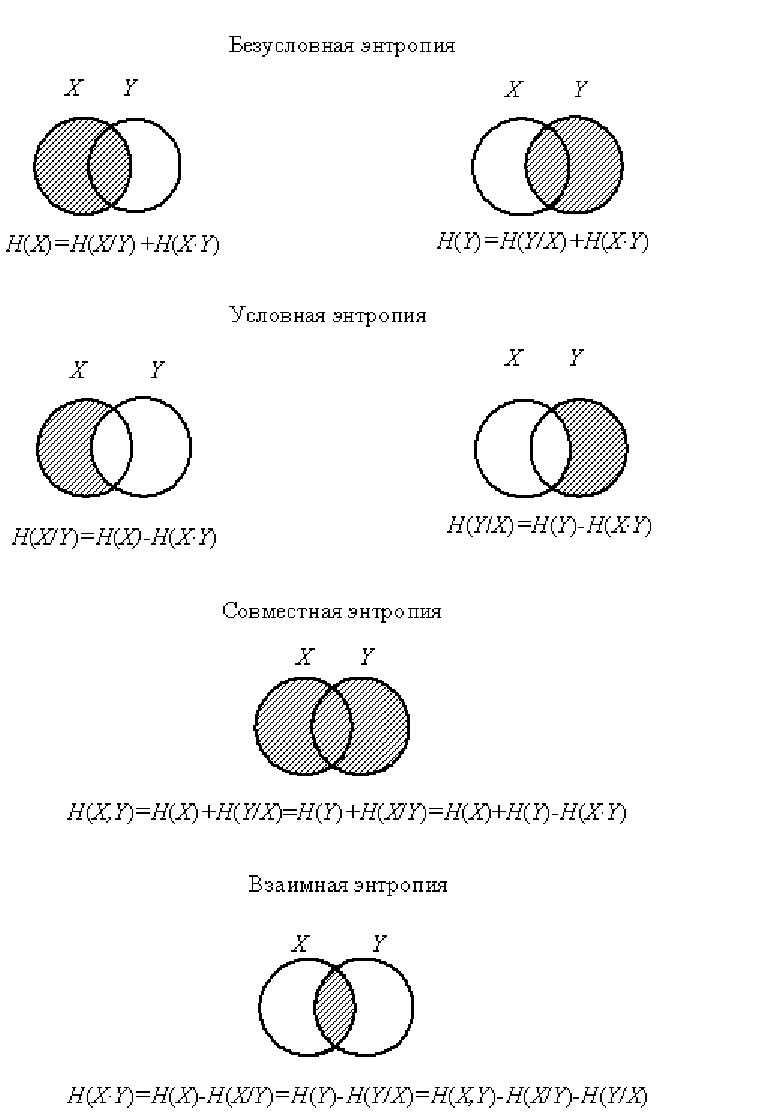

Уяснению соотношений между рассмотренными энтропиями дискретных ис-

точников информации (ансамблей) соответствует их графическое отображение

(рис. 1.2).

Рис. 1.2. Энтропия объединения

17

1.5. Количество информации от опыта в общем случае

Передача информации инициируется либо самим источником информации,

либо осуществляется по запросу. На приемной стороне любой системы переда-

чи информации до получения сигнала от интересующего нас источника неиз-

вестно, какой из возможных сигналов будет передан, но считается известным

распределение вероятностей Р(x

i

) по всем сигналам. Неопределенность ситуа-

ции до приема сигнала характеризуется энтропией:

).(log)()(

1

i

m

i

i

xPxPXH

∑

=

−=

(1.32)

Далее в приемное устройство поступает принятый сигнал. Поскольку

предполагается, что принятый сигнал соответствует переданному (помехи от-

сутствуют), то неопределенность относительно источника информации снима-

ется полностью.

Таким образом, в результате приема сигнала, с одной стороны, произошло

уменьшение неопределенности с Н(Х) до нуля, а с другой стороны, получено

количество информации I, численно

равное энтропии Н(Х). Отсюда следует,

что количество информации может быть определено как мера снятой неопреде-

ленности. Численное значение количества информации о некотором объекте

равно разности энтропий объекта до и после приема сигнала. Значит, понятие

энтропия является первичным, исходным, а понятие количество информации –

вторичным, производным понятием. Энтропия есть мера неопределенности,

а

количество информации – мера изменения неопределенности.

Если помехи существуют, то принятый сигнал в той или иной степени не

тождественен переданному. Здесь исчезает численное совпадение I и H. Коли-

чество информации будет меньше, чем при отсутствии помех, так как прием

сигнала не уменьшает энтропию до нуля.

Рассмотрим случай, когда между элементами сообщения

и помехой стати-

стические связи отсутствуют, искажения отдельных элементов сообщения яв-

ляются событиями независимыми и адресату известна совокупность условных

вероятностей

)1,1()/( mjmiyxP

ji

≤

≤

≤≤

того, что вместо элемента сооб-

щения x

i

будет принят элемент сообщения y

j

.

.

Среднее количество неопределенности, которым мы обладали до опыта,

равнялось Н(Х). Представим теперь что мы приняли какой-то сигнал y

j

и оцени-

ваем, какова неопределенность (после опыта) соответствия его некоторому пе-

реданному x

i

. Эта неопределенность равна

H(x

i

/

y

j

) = -logP(x

i

/

y

j

). (1.33)

Как видим, неопределенность этого соответствия является случайной ве-

личиной, значения которой при каждом заданном y

j

наступают с вероятностями

18

P(x

i

/y

j

). Поэтому среднее значение количества неопределенности соответствия

данного y

j

любому из x

i

равно

)./(log)/()/(

1

ji

m

i

jij

yxPyxPyXH

∑

=

−=

(1.34)

Величина H(X/y

j

) также случайна. Вероятности её значений равны P(y

j

).

Тогда среднее значение H(X/y

j

) определит среднее количество неопределённо-

сти соответствия любого y

j

любому из x

i

. Обозначим это среднее H(X/Y):

(1.35)

)./(log),()()/()/(

111

ji

m

i

m

j

jij

m

i

j

yxPyxPyPyXHYXH

∑∑∑

===

−==

Другими словами, H(X/Y) есть средняя неопределённость в передаче того

или иного x

i

, если известно, что принят тот или иной y

j

, или, кратко, средняя

неопределённость ансамбля X после опыта.

Таким образом, мы установили, что неопределённость передачи некоторо-

го сигнала Х до опыта Н(Х), а после опыта H(X/Y). Поэтому количество инфор-

мации, имеющееся в Y o X:

I(Y,X) = H(X) – H(X/Y). (1.36)

Эта мера количества информации получена нами на примере передачи со-

общений по каналу связи. Совершенно аналогичные рассуждения могут быть

применены к случайным объектам произвольного вида и приведут нас к той же

мере.

Подставим в выражение (1.36) необходимые значения H(X) и H(X/Y) из

(1.32) и (1.35) соответственно получим

∑∑

∑∑ ∑∑

∑∑∑

==

== ==

===

=

=+=

=+−=

m

i

m

j

ji

ji

ji

m

i

m

j

j

m

i

m

j

ijiiji

m

i

m

i

m

j

jijiii

yPxP

yxP

yxP

yxPyxPxPyxP

yxPyxPxxPXYI

11

11 11

111

.

)()(

),(

log),(

)/(log),()(log),(

)/(log),()log()(),(

(1.37)

Если частный характер количества информации специально не оговарива-

ется, мы всегда имеем дело с количеством информации, приходящимся в сред-

нем на один элемент сообщения. Поэтому указание об усреднении опускаются.

19

1.6. Основные свойства количества информации

1.6.1. I(X,Y) = I(Y,X), т.е. количество информации, содержащееся в случай-

ном объекте Y о случайном объекте Х, равно количеству информации, содер-

жащемуся в случайном объекте Х о случайном объекте Y. Свойство 1.6.1 сразу

же следует из (1.37), если учесть, что P(x

i

,

y

j

) = P(y

j

,

x

i

) .

1.6.2. ,0),( ≥

Y

X

I

причём знак равенства имеет место, когда объекты X и Y

независимы.

Положительность I(X,Y) следует из свойства энтропии : если события x

i

и y

j

статистически зависимы, то всегда H(Y/X) < H(Y) и H(X/Y) < H(X).

1.6.3. I(X,Y) = H(X), т.е. энтропия может быть истолкована как информация,

содержащаяся в объектах относительно самих себя. Из этого также непосредст-

венно вытекает, что энтропия есть максимальное количество информации, ко-

торое можно получить

об объекте. Это возможно при взаимно однозначном со-

ответствии между множествами передаваемых и принимаемых сообщений, что

имеет место в отсутствии помехи, апостериорная энтропия равна нулю и коли-

чество информации численно совпадает с энтропией источника.

Контрольные вопросы

1. В чём сущность требования аддитивности к мере неопределённости вы-

бора?

2. Назовите основной недостаток меры неопределённости, предложенной

Р. Хартли.

3. Укажите достоинства и недостатки способа, предложенного

К. Шенноном.

4. Что необходимо учитывать при выборе способа измерения количества

информации?

5. В каких единицах измеряется количество информации?

6. Дайте определение энтропии.

7. Назовите основные свойства

энтропии дискретного ансамбля.

8. Почему вводится понятие условной энтропии? Запишите выражение для

условной энтропии и поясните её смысл.

9. Приведите выражение для энтропии двух взаимосвязанных ансамблей.

10. Как связаны между собой понятия количества информации и энтропии?

11. В чём различаются понятия частного и среднего количества информа-

ции?

12. Когда энтропия источника с двумя

состояниями достигает максимума?

13. От чего не зависит энтропия случайного процесса?

14. Запишите выражение для энтропии объединения нескольких независи-

мых источников информации.

15. Перечислите свойства количества информации.

[1 с. 97-110; 2 с. 35-44; 6 с. 23-25].

20