Сорока Н.И., Кривинченко Г.А. Теория передачи информации

Подождите немного. Документ загружается.

51

Величина H(S

k

) случайно меняется в зависимости от состояния источника,

поэтому только среднее значение H(S

k

) может характеризовать энтропию ис-

точника:

åå

å

å

å

=

=

-

=

=

k

k

b

kbkb

k k kb

kbkbkkk

SSPSSP

SSPSSPSPSHSPXH

/

/

),/(log),(

)/(log)/()()()()(

где значок b/k у суммы означает, что производится суммирование по всем пере-

ходам из состояния S

k

в S

b

.

Таким образом, энтропия Н(Х) есть среднее значение (математическое

ожидание) энтропий всех характерных состояний источника.

В случае, когда символы источника независимы, имеется лишь одно состо-

яние S

1

, вероятность которого P(S

1

) = 1. При появлении символа x

i

источник

вновь возвращается в состояние S

1

(рис. 3.1), и при этом P(S

1

/S

1

) = P(x

i

), следо-

вательно,

),(log)()()(

1

1 i

n

i

i

xPxPSHXH

å

=

-==

что совпадает с (2.14).

Если коррелятивные связи имеются между двумя соседними символами, то

P(S

k

) = P(x

k

) и P(S

b

/S

k

) = P(x

b

/x

k

).

Из (3.3) тогда получим

11

() () (/)log(/)

nn

k bk bk

kb

H X Px Px x Px x

==

=-=

åå

11

дв.ед.

(,)log(/).

символ

nn

kb bk

kb

Pxx Pxx

==

=-

åå

(3.4)

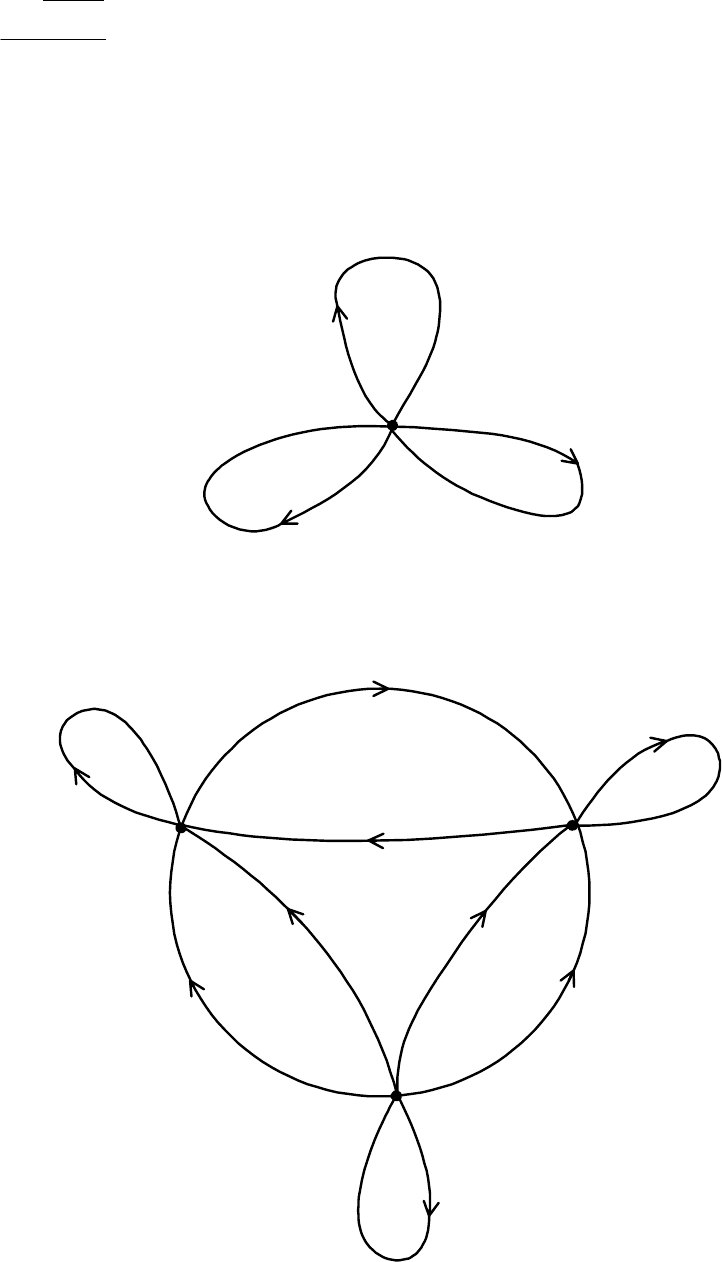

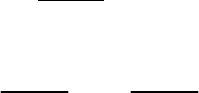

Источник, генерирующий n разных символов – x

1

,

x

2

,

...

,

x

n

, в этом случае

может иметь n характерных состояний. Пример такого источника для случая

n

=

3 приведён на рис. 3.2.

В случае когда коррелятивные связи имеются между тремя символами, ха-

рактерные состояния определяются передачей двух символов, и их удобно ну-

меровать двумя индексами. Так, если генерируются x

h

x

j

, то источник переходит

в состояние S

hj

и тогда:

P(S

hj

) = P(x

h

,x

j

) и P(S

ji

/S

hj

) = P(x

i

/x

h

,x

j

) .

Из (3.4) получаем

111

() (,) (/,)log(/,)

nnn

hj i hj i hj

hji

H X Px x Px x x Px x x

===

==

ååå

111

дв.ед.

(,,)log(/,).

символ

nnn

hji i hj

hji

Pxxx Px xx

===

=

ååå

(3.5)

(3.3)

52

Чисел характерных состояний для этого случая столько, сколько имеется

различных пар (x

i

,x

h

). Таких пар, очевидно, n

2

.

Аналогичные соотношения получаются и в случае, когда коррелятивные

связи распространяются на большее число символов.

3.2. Свойство энтропии эргодических источников

Теорема 1. Для любых

0

>

e

и

0

>

d

можно найти такое M

0

, при котором

эргодические последовательности с длиной

0

MM

>

распадаются на два класса:

1) типичные, вероятности которых удовлетворяют следующему неравен-

ству:

,

)(

1

log

)( d<-

M

CP

XH (3.6)

где Н(Х) – энтропия эргодического источника;

2) нетипичные, сумма вероятностей которых меньше e.

Доказательство. Последовательность C длины M образуется в результате

поочередного перехода источника из одного характерного состояния в другое.

Рассмотрим переход из состояния S

k

в состояние S

b

во множестве последо-

вательностей С. Число M всегда может быть выбрано настолько большим, что

сумма вероятностей всех нетипичных последовательностей меньше e. Учиты-

вая, что для типичной последовательности частота событий может быть как

угодно близка к их вероятности, можно утверждать, что в каждой типичной по-

следовательности источник пребывает в состоянии S

k

приблизительно M

p

(S

k

)

раз, а число переходов из состояния S

k

в состояние S

b

приблизительно равно

M

p

(S

k

) P(S

b

/S

k

), а точнее

M(P(S

k

) P(S

b

/S

k

) ± h), (3.7)

где h с увеличением M может быть сделано как угодно малым.

Вероятность того, что в рассматриваемой последовательности имеет место

М переходов из состояния S

k

в S

b

, равна по теореме умножения вероятностей

.)/(

))/()((

h

±

kbk

SSPSPM

kb

SSP (3.8)

Вероятность появления конкретной последовательности С определяется

как вероятность всех возможных переходов, и, следовательно,

.)/()(

))/()((

/

h

±

ÕÕ

=

kbk

SSPSPM

k kb

kb

SSPCP

(3.9)

53

Логарифмируя последнее равенство, получаем:

)/log()/(log)/()(

)(

1

log

//

k

k kb

bkbk

k kb

bk

SSSSPSSPSP

M

CP

åååå

h±-= .(3.10)

Если учесть, что первая сумма в правой части совпадает с (3.3), а вторая

вследствие произвольной малости h всегда может быть меньше d, то получим

неопределённость (3.6).

P(x

1

)

P(x

2

)

P(x

3

)

S

1

P(x

1

/x

1

)

P(x

2

/x

1

)

P(x

2

/x

2

)

P(x

1

/x

3

)

P(x

1

/x

2

)

P(x

3

/x

1

)

P(x

2

/x

3

)

P(x

3

/x

2

)

P(x

3

/x

3

)

S

3

(x

3

)

S

1

(x

1

)

S

2

(x

2

)

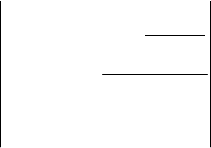

Рис. 2.1. Диаграмма перехода, когда источник имеет

одно характерное состояние

Рис. 2.2. Диаграмма перехода, когда источник имеет

три характерных состояния

54

Следствие 1. Типичные последовательности приблизительно равноверо-

ятны. Для доказательства из (3.6) найдём Р(С):

.2)(2

)()( d--d+-

<<

HMHM

CP

При

.

0

,

®

d

¥

®

M

Поэтому при достаточно большом М можно положить

P(C) » 2

-MH(X)

.

(3.11)

Из (2.11) видно, что все последовательности С равновероятны и число их

N

T

= 2

MH(X)

. (3.12)

В случае, если все n символов источника независимы и равновероятны, то

N

T

= 2

Mlogn

= n

M

. (3.13)

Легко видеть, что (3.13) определяет число всех возможных последователь-

ностей длины М, содержащих n различных символов.

Следствие 2. Чтобы экспериментально определить энтропию эргодиче-

ского источника, у которого вероятностные связи распространяются на очень

большое число символов, нам необходимо располагать последовательностью

ещё большей длины (

r

M

>>

); при этом вычисленная энтропия будет как угодно

близка к своему пределу log1/P(C) = H(X).

3.3. Избыточность источника сообщений

Как известно, энтропия характеризует среднее количество информации,

несомое одним символом источника. Она максимальна, когда символы выраба-

тываются источником с равной вероятностью. Если же некоторые символы по-

являются чаще других, энтропия уменьшается, а при появлении дополнитель-

ных вероятностных связей между символами становится ещё меньше. Чем

меньше энтропия источника отличается от максимальной, тем рациональнее он

работает, тем большее количество информации несут его символы.

Для сравнения источников по их информативности введём параметр, назы-

ваемый избыточностью, равный

.

)(

)()(

max

max

XH

XHXH

R

-

= (3.14)

Источник, избыточность которого R = 0, называется оптимальным. Если

R

=

1, то Н(Х) = 0, и, следовательно, информация, вырабатываемая источником,

равна нулю. В общем случае

.

1

0

£

£

R

Чем меньше избыточность R, тем раци-

ональнее работает источник.

55

Следует, однако, иметь в виду, что не всегда нужно стремиться к тому,

чтобы R = 0. Некоторая избыточность бывает полезной для обеспечения надеж-

ности передачи сообщений. Простейшим видом введения избыточности для

борьбы с шумами является многократная передача одного и того же символа.

3.4. Поток информации источника сообщений

При работе источника сообщений на его выходе отдельные символы появ-

ляются через некоторые интервалы времени; в этом смысле мы можем говорить

о длительности отдельных символов, и, следовательно, может быть поставлен

вопрос о количестве информации, вырабатываемой источником в единицу вре-

мени.

Длительность выдачи знаков источником в каждом состоянии в общем

случае может быть различной. Тогда средняя длительность выдачи источником

одного знака:

,)()(

å

å

t

=

t

k i

ik

i

x

xPSP (3.15)

где P(S

k

) – вероятность того, что источник сообщений находится в состоянии

S

k

; P(x

i

) – вероятность появления символа x

i

в состоянии S

k

; t

xi

– длительность

выдачи знака x

i

источником в состоянии S

k

.

Энтропия источника, приходящаяся на единицу времени, может быть

названа скоростью создания сообщений, или потоком информации, т.е.

( ) дв.ед.

().

с

HX

HX =

t

(3.16)

Если длительность выдачи знака не зависит от состояния источника, для

всех знаков одинакова и равна

,

t

то

.

t

=

t

Выражение для )(XH принимает

вид:

.

с

дв.ед.)(

)(

t

=

XH

XH (3.17)

В этом случае поток информации максимальный, если энтропия источника

на символ максимальна. Для увеличения потока информации необходимо по

возможности уменьшить среднюю длительность символов

t

. С этой целью,

например, необходимо, чтобы длительность тех символов, вероятность появле-

ния которых больше, была меньше, чем для символов, вероятность появления

которых относительно велика. Таким образом, для получения большого потока

информации на выходе источника необходимо не только обеспечить по воз-

56

можности большую энтропию на символ, но и правильно выбрать длительность

разных символов.

КОНТРОЛЬНЫЕ ВОПРОСЫ

1. Дайте определение эргодическому источнику.

2. Запишите выражение для энтропии эргодического источника, когда кор-

релятивные связи имеются между двумя и тремя символами.

3. Приведите диаграмму переходов, когда источник имеет четыре харак-

терных состояния.

4. Перечислите свойства энтропии эргодических источников.

5. Что характеризует избыточность источника сообщений?

6. Что понимается под потоком информации источника сообщений?

4. ИСТОЧНИКИ НЕПРЕРЫВНЫХ СООБЩЕНИЙ

4.1. Дифференциальная энтропия

Источники информации, множество возможных состояний которых со-

ставляют континуум, называют непрерывными.

Во многих случаях они преобразуются в дискретные посредством исполь-

зования устройств дискретизации и квантования. Вместе с тем существует не-

мало и таких систем, в которых информация передаётся и преобразуется непо-

средственно в форме непрерывных сигналов. Примерами могут служить систе-

мы телеизмерений с частотным разделением сигналов.

Основные информационные характеристики источников непрерывных со-

общений следующие: энтропия, условная энтропия, эпсилон

–

энтропия, эпси-

лон

–

производительность, избыточность, объём информации.

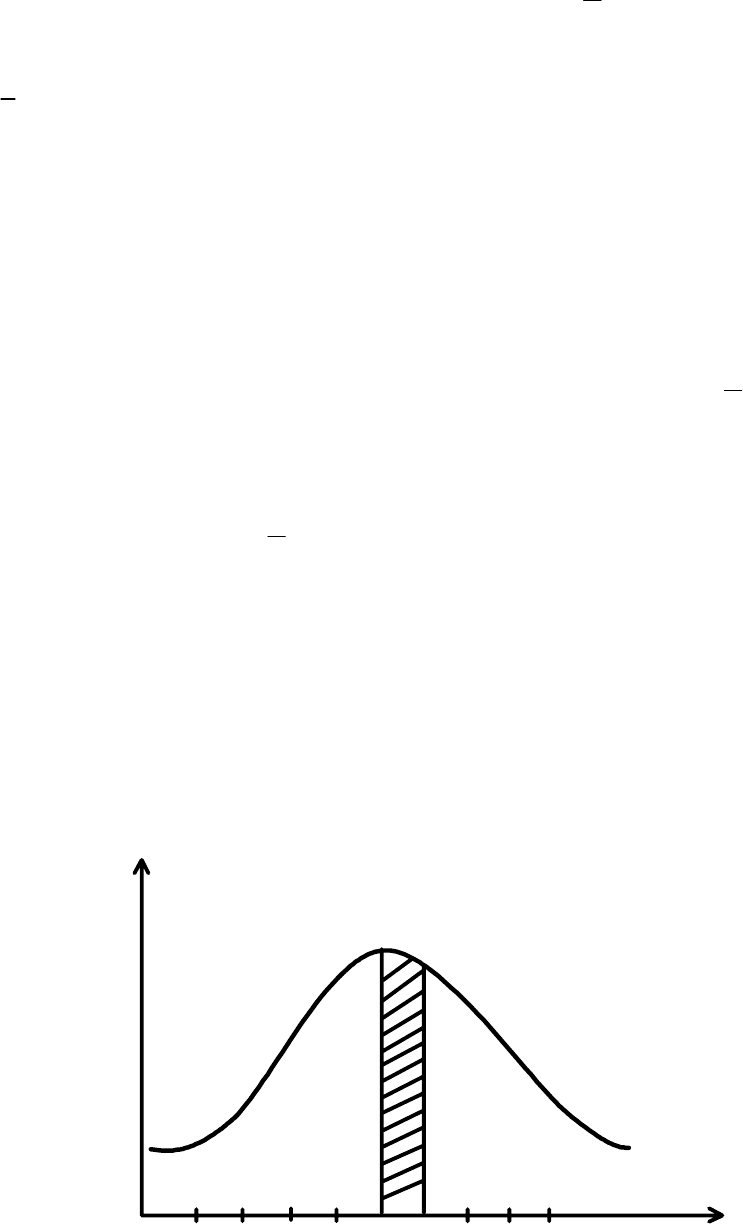

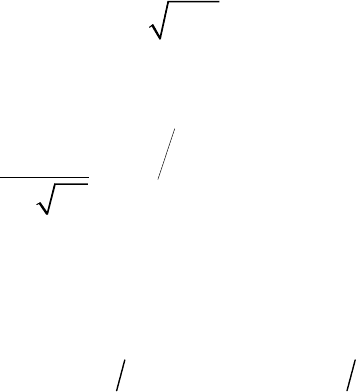

Формулу для энтропии источника непрерывных сообщений получают пу-

тем предельного перехода из формулы (2.14) для энтропии дискретного источ-

ника. С этой целью разобьём диапазон изменения непрерывной случайной ве-

личины Х, характеризующейся плотностью распределения вероятностей W(X),

на конечное число m малых интервалов шириной Dx (рис. 4.1).

При реализации любого значения х, принадлежащего интервалу [x

i

, x

i

+Dx],

будем считать, что реализовалось значение x

i

дискретной случайной величины

Х. Поскольку Dx мало, то вероятность )( xxxxP

ii

D

+

£

£

реализации значения

х из интервала [x

i

, x

i

+Dx] равна

.)()()( xxWdxxWxxxxP

xx

x

ii

i

i

D»=D+<<

ò

D+

57

Тогда энтропия дискретной случайной величины

X

может быть записана

в виде

1 11

( ) () log () () log () () log

m mm

i ii

HX Wx x Wx x Wx x Wx Wx x x

= ==

=- D D=- D - D D=

å åå

1

( ) log ( ) log ,

m

i

Wx x Wx x

=

=- D -D

å

(4.1)

так как

å

=

=D

m

i

xxW

1

.1)(

По мере уменьшения )( xxxxPx

i

D

+

<

<

D

все больше приближается к ве-

роятности P(x

i

), равной нулю, а свойства дискретной величины

X

– к свой-

ствам непрерывной случайной величины Х.

В результате предельного перехода при

0

®

D

x

получено

ò

¥

¥

-

®D®D

D--=-= .loglim)(log)()(lim)(

00

xdxxWxWXHXH

xx

(4.2)

Первый член выражения (4.2) зависит только от закона распределения не-

прерывной случайной величины Х и имеет такую же структуру, как энтропия

дискретного источника. Второй член

x

x

D

®D

loglim

0

стремится к бесконечности,

это полностью соответствует интуитивному представлению о том, что неопре-

деленность выбора из бесконечно большого числа возможных состояний (зна-

чений) бесконечно велика.

Рис. 3.1. Зависимость плотности распределения вероятностей

случайной величины

123

x

i

x

x

D

m

W(x)

x

i

+

58

Чтобы избавить теорию от бесконечности, имеется единственная возмож-

ность – ввести относительную меру неопределенности исследуемой непрерыв-

ной случайной величины Х по отношению к заданной Х

0

. В качестве заданной

величины Х

0

возьмем непрерывную случайную величину, равномерно распре-

деленную на интервале с шириной

a

-

b

=

e

. Тогда её плотность вероятности

е1)(

0

=

XW

, а энтропия

β

0

00

11

( ) log lim log log

ε lim log

εε

xx

HXdxxx

D® D®

a

=- -D=-D

ò

.

Положив для простоты записи e = 1, составим разность

,)()log()()()(

0

ò

¥

¥

-

D

-=-= dxXWXWXHXHXH

(4.3)

которая показывает, насколько неопределенность непрерывной случайной ве-

личины Х с законом распределения W(X) больше

[

]

0)( >

D

XH

или меньше

[

]

0)( <

D

XH

неопределенности случайной величины, распределенной равномер-

но на интервале e = 1. Поэтому величину

ò

¥

¥

-

D

= dxXWXWXH )(log)()( (4.4)

называют относительной дифференциальной энтропией или просто диф-

ференциальной энтропией непрерывного источника информации (непрерывно-

го распределения случайной величины Х). В отличие от энтропии источников

дискретных сообщений

)(XH

D

может принимать положительные, отрицатель-

ные и нулевые значения. Величиной

)(XH

D

можно характеризовать информа-

ционные свойства источников непрерывных сообщений.

Аналогично, используя операции квантования и предельного перехода,

найдем выражение для условной энтропии непрерывного источника сообще-

ний.

0

(,)

( ) ( , )log lim log

()

x

W xy

HXYWxy dxdyx

Wy

¥¥

D®

-¥ -¥

=- -D

òò

. (4.5)

Обозначим первый член через )( YXH

D

:

(,)

( ) ( , )log

()

W xy

H X Y W x y dxdy

Wy

¥¥

-¥ -¥

D

=-

òò

. (4.6)

59

Эта величина конечна и называется относительной дифференциальной

условной энтропией, или просто дифференциальной условной энтропией не-

прерывного источника. Она характеризует неопределенность выбора непре-

рывной случайной величины Х при условии, что известны результаты реализа-

ции значений другой статистически связанной с ней непрерывной случайной

величины Y, и по сравнению со средней неопределенностью выбора случайной

величины Х

0

, изменяющейся в диапазоне, равном единице, и имеющей равно-

мерное распределение вероятностей.

4.2. Свойства дифференциальной энтропии

1. Величина )(

Д

XH изменяется при изменении масштаба измерения Х.

Изменим масштаб случайной величины Х в k раз, оставив неизменным

масштаб равномерно распределенной в единичном интервале случайной вели-

чины Х

0

, принятой за эталон. Если x

i

= kx, то

k

xW

xW

i

)(

)( =

. Тогда

() ()

( ) ( )log ( ) log

ii

Wx Wx

H X W x W x dx kdx

i

kk

D

¥¥

-¥ -¥

æö

¢

=- =- =

òò

ç÷

èø

()log () log () ( ) log .

W x W xdx k W xdx H X k

D

¥¥

-¥ -¥

=- + =+

òò

(4.7)

Если одновременно изменить масштаб Х

0

, соотносительная неопределен-

ность также изменится, так как значение эталона будет уже иным.

Из относительности дифференциальной энтропии следует, что энтропия

может принимать положительные, отрицательные и нулевые значения.

2. Дифференциальная энтропия не зависит от конкретных значений слу-

чайной величины Х и, в частности, от изменения всех её значений на постоян-

ное. Действительно, масштаб Х при этом не меняется и справедливо равенство

( ) ()log() )

H X Wx Wx d(x

D

¥

-¥

+q=- +q +q +q=

ò

()log () ( )

Wx Wxdx H X .

¥

D

-¥

=-=

ò

(4.8)

3. Если единственным ограничением для случайной величины Х является

область её возможных значений [a, b], то максимальной дифференциальной эн-

тропией обладает равномерное распределение вероятностей в этой области, т.е.

при W(X) = (b - a)

-1

:

60

Δ

( ) log( )

HX

= b-a

. (4.9)

4. Если ограничения на область значений непрерывной случайной величи-

ны Х отсутствуют, но известно, что дисперсия её ограничена, то максимальной

дифференциальной энтропией, равной

maxx

() log2

πe

HХ

D

=s

, (4.10)

обладает нормальное (Гауссовское) распределение величин Х:

22

2

1

()

2π

x

x

x

WXe

-s

=

s

. (4.11)

5. Соотношения для дифференциальной энтропии объединения статисти-

чески зависимых непрерывных источников аналогичны соответствующим

формулам для дискретных источников:

(,) () () () ()

HXY HX HYX HY H XY

D D D DD

=+ =+

, (4.12)

где

òò

-=

¥

¥-

¥

¥-

D

dxdyyxWyxWYXH ),()log,(),(

.

6. Если статистические связи между X и Y отсутствуют, то

)()(),( YHXHYXH

DDD

+

=

. (4.13)

4.3. Эпсилон - энтропия источника сообщений

Реальная чувствительность приемных устройств, органов чувств человека

и разрешающая способность различных информационно-измерительных систем

ограничены. Поэтому воспроизводить непрерывные сообщения абсолютно точ-

но не требуется. Наличие помех и искажений сигналов в реальных каналах де-

лает точное воспроизведение сообщений невозможным. Поэтому введём поня-

тие эпсилон–энтропии. Эпсилон–энтропия – это то среднее количество инфор-

мации в одном независимом отсчете непрерывного случайного процесса Х(t),

которое необходимо для воспроизведения этого сигнала с заданной средне-

квадратичной погрешностью e

о

.

Рассмотрим подробнее сущность этого понятия. Предположим, что пере-

давался сигнал Х(t), а был принят сигнал Y(t). Пусть в канале действует адди-

тивная помеха E(t), тогда Y(t) = X(t) + E(t) . Расстояние между сигналами X(t) и

Y(t) определяется величиной