Федотов В.Х. Нейронные сети в MS Excel

Подождите немного. Документ загружается.

31

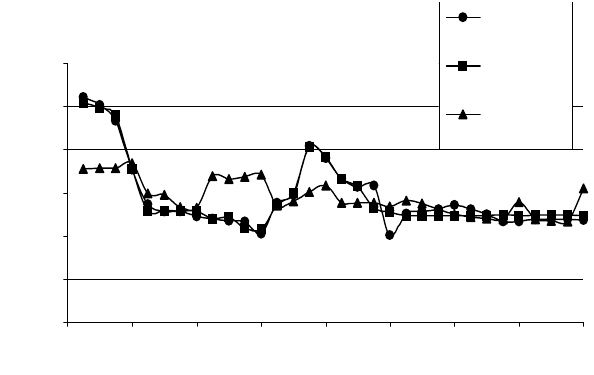

Как видно из таблицы, результаты нейромоделирования

хорошо аппроксимируют фактические данные и общая

квадратичная ошибка составляет всего 0,01%. Приближенное

уравнение регрессии, полученное на основе нейромоделирования,

конечно, содержит большую ошибку, но тоже всего 0,15% (хуже

в 15 раз). Графическая иллюстрация таблицы приведена ниже.

Сравнение фактического уровня инфляции с нейропрогнозом

80

90

100

110

120

130

140

0 4 8 12 16 20 24 28 32

Кварталы

ИПЦ,%

ИПЦ

ИПЦ

(Predicted)

ИПЦ(расч по

ур.нейрорегр)

Новый сеанс работы с нейросетью

Если нейросеть была создана в предыдущем сеансе работы с

Excel, то сохраненный ранее проект можно использовать для

работы с новыми данными. Эти данные обязательно должны

иметь тот же формат, как и те, по которым сеть обучалась. Для

этого предназначена кнопка Load Project (Загрузить проект) на

вкладке

Data.

Вспомним, что наш нейропроект хранится в файле

Vavilon.wnp, а Excel-таблица с исходными данными и

результатами предыдущего моделирования в файле Vavilon.xls.

Для загрузки файла проекта нейросети из файла Vavilon.xls

необходимо вновь запустить программу Winnet и в окне Select

data source восстановить прежние параметры диапазона данных

для нейромоделирования.

32

Алгоритм 2. Повторное обучение персептрона «4-3-1»

1. Загрузим сохраненные ранее данные в Excel. Для этого

откроем нашу книгу Vavilon.xls.

2. Загрузим созданный ранее проект. Нажмем кнопку

Нейроэмулятор на панели инструментов Neural Analysis. В

появившемся окне Select data source вновь укажем размещение

нашей таблицы (количество и порядок столбцов новых данных

обязательно должны совпадать с использованными при создании

проекта и

обучении нейросети). Столбцы, используемые в

качестве выходов, можно занулить или игнорировать. Зададим:

колонки =D-К, первая строка =2, последняя строка =34 и

включим флажок Использовать первую строку в качестве

имен входов. Нажимаем ОК.

Замечание. Имеется и более быстрый способ загрузки

проекта. Если перед загрузкой нейроэмулятора выделить

диапазон с исходными данными на листе Excel, то после

запуска

нейроэмулятор автоматически заполнит параметры размещения

наших исходных данных.

3. Загрузим созданный ранее проект. Для этого перейдем на

вкладку Data и нажмем кнопку Load Project (Загрузить

проект). В открывшемся окне выберем файл нашего проекта

Vavilon.wnp и завершим загрузку командой Открыть.

4. Теперь мы можем продолжить работу с нейросетью

аналогично тому, как это было

проделано выше – в алгоритме 1.

Например, перейдем на закладку Network и вновь увидим

графическое изображение нейросети с архитектурой «4-3-1».

Здесь мы делать ничего не будем.

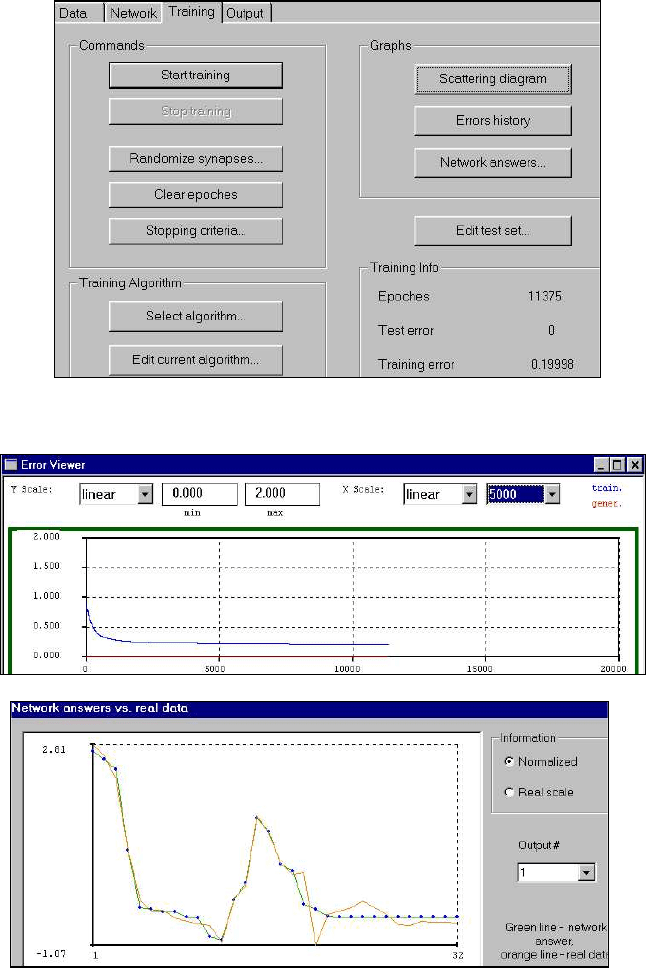

5. Перейдем дальше на закладку Training, зададим прежние

параметры обучения – критерий остановки по ошибке равной 0,2

(использовать критерии остановки) и начнем обучение – Start

Training.

33

Просмотрим график ошибок. Видно, что стабилизация

ошибки происходит в районе 7000-8000-й эпох, т.е. примерно так

же, как и раньше.

Отклик сети (Network answer) также подобен прежнему.

34

6. Перейдем на закладку Output, зададим параметры

сохранения результатов в книге Excel так же, как это делалось

раньше.

7. Сам нейропроект можно не сохранять, так как мы не

вносили в него изменений.

8. Заканчиваем сеанс работы с нейросетью, закрывая окно

программы Winnet.

Модификация модели «Вавилон»

На этом примере мы попытаемся более детально

познакомиться

с процессом обучения нейронной сети, особенно

останавливаясь на тех моментах нейромоделирования, которые

были мало затронуты в предыдущих примерах.

Попытаемся улучшить качество нейромодели, уменьшая

число связей за счет дальнейшего сокращения малозначащих

входов. О том, что это возможно, уже упоминалось при

рассмотрении алгоритма 1 (см. п.9).

Алгоритм 3. Персептрон с архитектурой «2-3-1»

1. Вновь загрузим книгу Vavilon.xls с сохраненными ранее

данными в Excel.

2. Вновь загрузим сохраненный файл проекта Vavilon.wnp с

прежними параметрами расположения исходных данных.

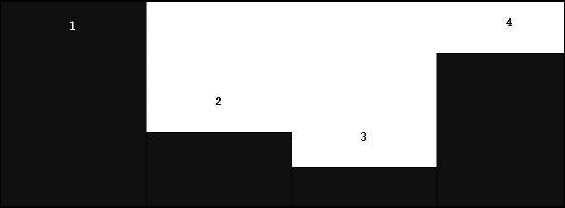

3. Продолжим работу с нейросетью. Перейдем на закладку

Data и выполним команду Boxcounting, чтобы просмотреть

диаграмму значимости входов модели.

4. Видно, что входы 2 и 3 менее значимы. Удалим вначале

вход 3. Как это делается, мы уже рассматривали в алгоритме 1.

Посмотрим параметры нормализации. Они практически не

изменились - среднее стало 0,063 (было 0,062). Поэтому удалим

35

и вход номер два. Вновь посмотрим параметры нормализации.

Они опять почти не изменились - среднее стало 0,066. Это

означает, что удаление этих двух входов практически не

повлияет на прогностические свойства нейромодели. Однако

новый вариант модели будет лучше соответствовать

необходимому условию успешного обучения - число образцов

должно быть значительно больше числа связей. Кроме того,

такая

модель будет проще – что неплохо.

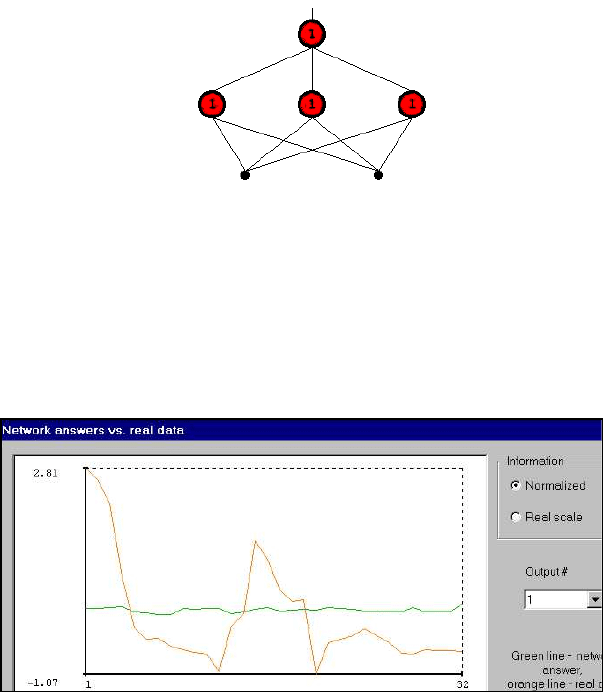

5. Перейдем на закладку Network и выполним команду

Create Network. Получим сеть «2-3-1».

6. Приступим к ее обучению. Перейдем на вкладку Training.

Установим критерий остановки (Stopping criteria) по количеству

эпох = 100 000, ошибке обучения <= 0,2 и включим флажок

Использовать критерии остановки (Use stopping criteria).

Выполним операцию рандомизации синапсов (Randomize

sinapses + ОК). Увидим, что начальная ошибка обучения

составила 0,98195. Эта ошибка обусловлена первоначальным

откликом сети, который можно посмотреть по команде Network

answer.

36

Видно, что начальный отклик (зеленая почти горизонтальная

линия) плохо согласуется с обучающей выборкой (оранжевая

линия). Напомним, что у вас могут получиться другие

результаты, что связано с работой генераторов случайных чисел.

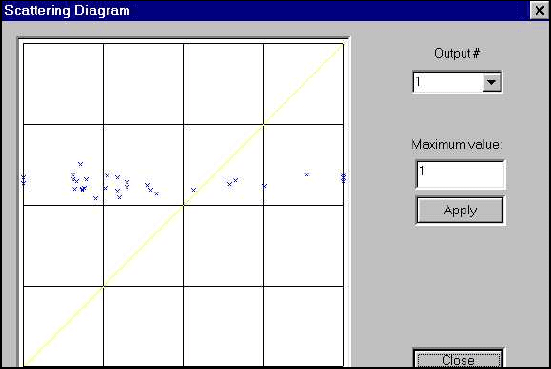

Соответствующий начальный График разброса (Scattering

diagramm) имеет вид, показанный на следующей диаграмме. Эта

диаграмма показывает, как классифицируются наши обучающие

примеры при

данном выборе начальных значений весов. Видно,

что выше прямой лежит примерно 75% обучающих примеров, а

остальные 25% - ниже. Можно сказать, что это - начальный

интеллект необученной сети («детский уровень»). Заметим, что

необученную сеть можно рассматривать и как обученную, если

допустимую ошибку сети принять, например, равной 0,99.

7. Попытаемся улучшить начальные установки сети. Для

этого «встряхнем» веса, т.е. выполним повторную рандомизацию

синапсов (Randomize sinapses + ОК). Увидим, что начальная

ошибка обучения даже возросла и составила 1,14225. Это

говорит о том, что начальные условия ухудшились и время

достижения состояния «завершения обучения» при этом будет

больше. Поэтому «повстряхиваем» нашу сеть еще и

еще раз до

тех пор, пока начальная ошибка не станет приемлемой, например

<0,5. После многократных попыток, даже меняя диапазон выбора

весов, убеждаемся, что это не получается.

37

То, что мы сейчас проделали, было не чем иным, как

попыткой обучить нашу нейронную сеть «вручную», методом

«научного тыка», т.е. без использования специальных

алгоритмов обучения. Как мы смогли убедиться, это не очень

просто сделать.

Поэтому удовлетворимся выбором менее жесткого

требования – уменьшением начальной ошибки хотя бы до 0,95.

После нескольких попыток

убеждаемся, что эта задача вполне

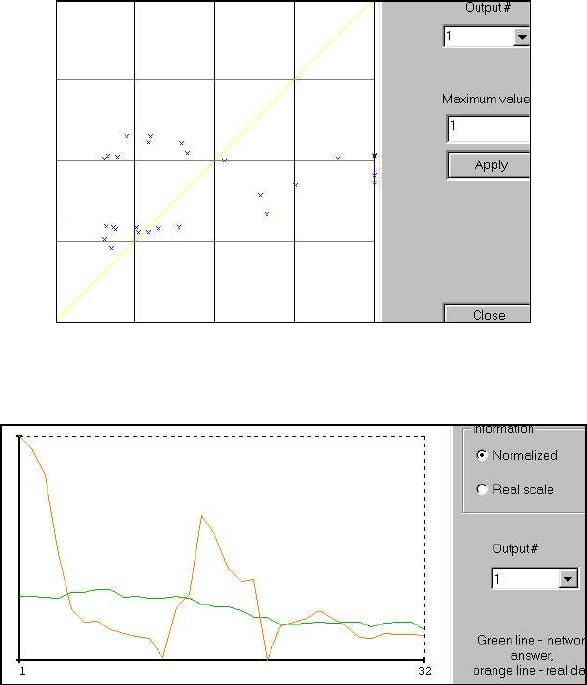

реализуема и получаем Training error =9,4668. Диаграмма

разброса принимает несколько другой вид – ниже прямой

находится уже примерно 40% образцов.

Для наглядности рекомендуется для каждого выбора весов

просматривать не только диаграмму разброса, но и

соответствующий график Network answer. Видно, что и он

несколько лучше, чем предыдущий.

38

8. Начнем обучение. Попробуем вновь снизить ошибку

обучения до 0,5, но уже с помощью алгоритмов обратного

распространения ошибки. Установим в окне Критерии

остановки (Stopping criteria) предельную ошибку обучения

равной 0,5. Нажмем Start Training. Ждем результатов обучения.

В процессе ожидания можно наблюдать за ходом обучения по

изменению ошибки сети или с помощью всех графических

средств отображения процесса

обучения. Видно, что ошибка

обучения хоть и очень медленно, но уменьшается.

Соответственно меняется график ошибок и диаграмма разброса.

Отклик сети пока недоступен.

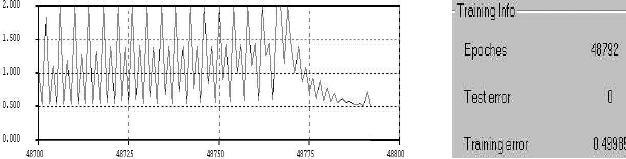

Обучение остановилось. Видим, что даже заданных 100 000

эпох не хватило для достижения требуемой ошибки обучения.

Остановка обучения произошла по истечении числа эпох и

ошибка на начало 100 001-й эпохи составила 0,51715.

9. Продолжим обучение. Это можно сделать различными

способами: увеличением числа эпох обучения, выбором других

значений начальных весов, очисткой эпох и др. Выберем,

например, вариант Очистка эпох (Clear epoches). Это означает,

что текущее значение эпохи будет уменьшено на 100 000, т.е.

вновь примет значение = 1, а конечное значение ошибки

предыдущего цикла обучения (0,51715) будет принято в качестве

начального для данного, нового цикла обучения сети. Нажмем

Start Training. Этот процесс, возможно, придется повторить

многократно до тех пор, пока ошибка обучения не достигнет

заданного уровня. В нашем примере это пришлось сделать

примерно десять раз. Это говорит о том, что алгоритмы

оптимизации, используемые при обучении сети, попали на склон

длинного пологого оврага

(см. рис. ниже), и для достижения его

дна (глобального минимума) потребовалось порядка миллиона

эпох (итераций). После чего был получен требуемый результат.

Движение к дну длинного оврага Ошибка обучения

39

Заметим, что на самом деле мы несколько схитрили – не

стали ждать, пока алгоритм медленно проберется к минимуму, а

Скорректировали параметры самого алгоритма (Edit current

algorithm), увеличив (пока просто интуитивно) шаг

корректировки Nu(-) с 0,5 до 0,9. Остальные параметры были

оставлены без изменения.

Таким образом, мы посмотрели, как можно проводить

обучение. Отметим, что это далеко не единственный вариант и

возможны другие схемы реализации успешного обучения.

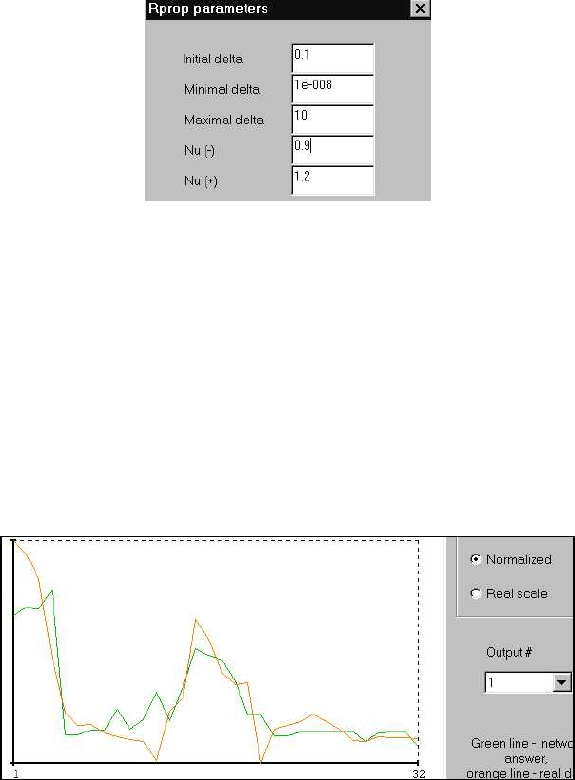

10. Посмотрим результаты обучения. Для этого обратимся к

графику Отклика сети(Network answer). Видно, что все

примеры неплохо воспроизводятся нейросетью «2-3-1».

11. Продолжим обучение дальше, так как ошибка на уровне

0,5 не может считаться приемлемой. Попытаемся ее уменьшить.

Установим в окне Критерии остановки (Stopping criteria)

предельную ошибку обучения 0,25. Увеличим предельное число

эпох до 1 миллиона. Конечное значение ошибки предыдущего

цикла обучения (0,49985) будет принято в качестве начального

для очередного цикла обучения сети. Нажмем Start Training.

40

Наблюдая за ходом обучения, можно увидеть, что мы вновь

сталкиваемся с проблемой «длинного оврага», т.е. медленного

уменьшения ошибки обучения. Попытки улучшить параметры

алгоритма обучения также не дали существенных преимуществ.

Вот где не помешали бы вычислительные ресурсы хорошей

супер-ЭВМ. Но все же многое зависит и от нас – пользователей.

На 412

390-й эпохе процесс обучения остановился. Достигнутая

точность составила 0,24998. Получившийся отклик сети

приведен ниже. Видно, что он значительно улучшился -

примерно десять первых образцов сеть воспроизводит

практически без ошибок, но и дальше – совпадение неплохое.

Таким образом, с помощью нейросети типа «2-3-1» мы

получили результат, сравнимый по качеству с помощью более

сложной модели «4-3-1», рассмотренной

выше.

12. Перейдем на закладку Output, зададим параметры

сохранения результатов в Excel: лист – Нейросеть2_3_1, начало

диапазона вывода – А1 и установим флажок вывести Только

отклик сети (Only network answer).. Завершаем сохранение

результатов работы нейросети нажатием клавиши Output.

13. Сохраним нейропроект под именем Vavilon2_3_1.wnp.

14. Закончим сеанс работы с нейросетью.

15. Теперь, конечно, хотелось бы посмотреть почти

самое

главное – материализованный результат нашей работы –

значения весов нейронной сети. Но, к сожалению, программа не

предоставляет такой возможности. Это, впрочем, не уменьшает

ее исследовательской ценности, так как все необходимые

параметры сети (включая и веса синапсов) запомнены в файле

нашего нейропроекта и мы, хоть и в неявной форме, разумеется,