Будко В.Н. Человек - интерфейс - компьютер

Подождите немного. Документ загружается.

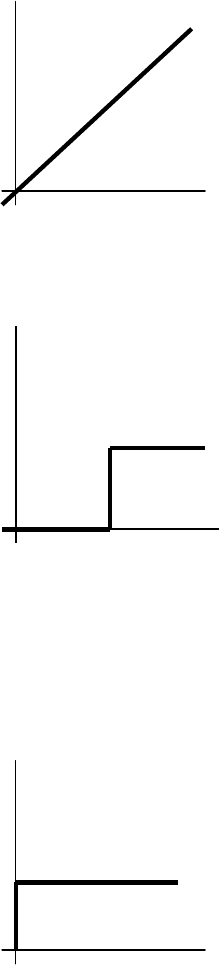

8.3 Вычисление сигнала активности

1.Тождественная функция

2. Пороговая функция

<

≥

=

Vnet

Vnet

netf

,0

,1

)(

3. Смешанная пороговая функция

i

n

i

i

WXnet

∑

=

=

1

,

<

≥

=

0,0

0,1

)(

net

net

netf

Сдвиг удобно представить как весовой коэффициент W

0

от скрытого элемента

постоянной величины X

0

=1

f(net)

net

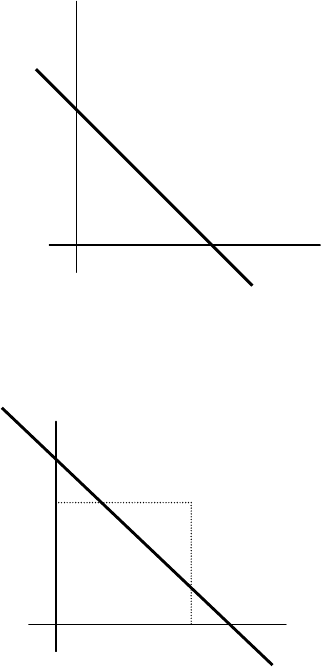

Рис 8.4 (а )

Рис 8.4 (б )

f(net)

net

f(net)

net Рис 8.4(в)

∑

=

=

n

i

ijij

WXnet

0

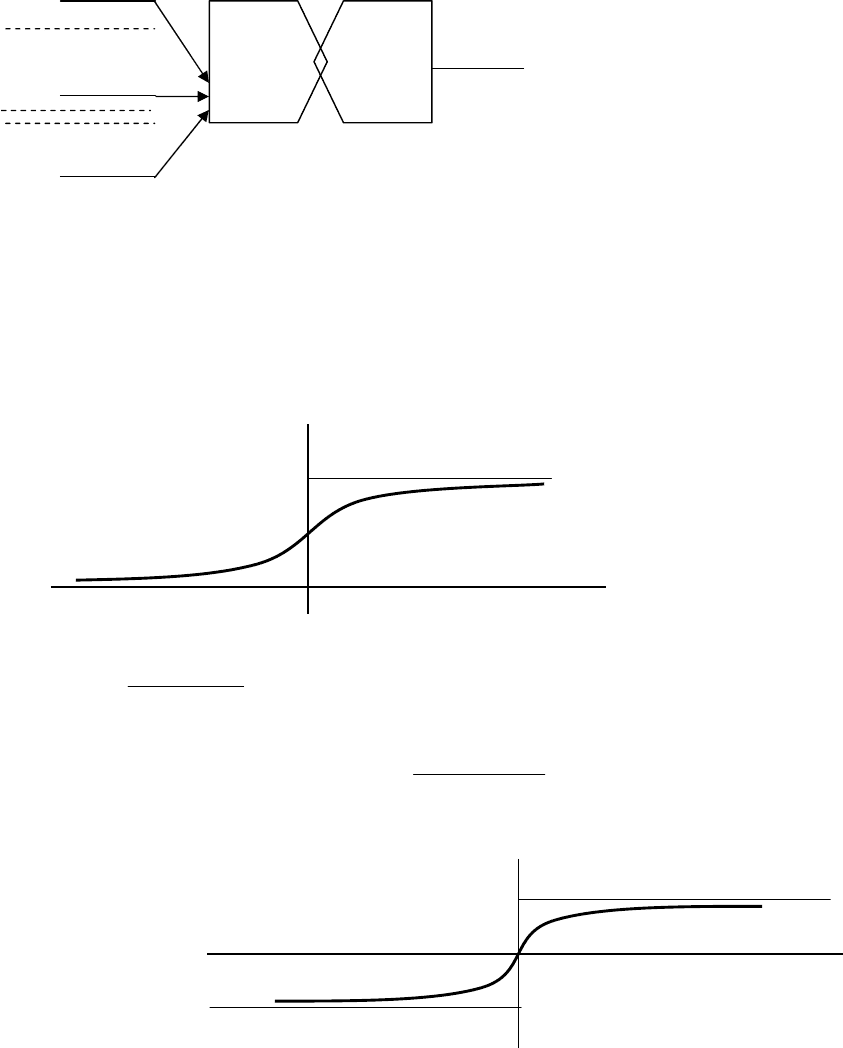

В сложных задачах применяются, как в биологическом нейроне , плавные пороговые

функции вместо скачка

4. Сигмоидальная (логистическая) функция

)(1

1

)(

netext

netf

−+

=

5. Гиперболический тангенс

)*2(1

2

1)(

netext

netf

+

−=

Y

j

X

0

W

0j

X

1

W

1j

X

n

W

nj

j

-

й нейтрон

Рис 8.5

f(net)

0,5

Рис 8.6(а )

1

net

Рис 8.6(б )

1

-

1

net

f(net)

Рис 8.6 (в)

f(net)

net

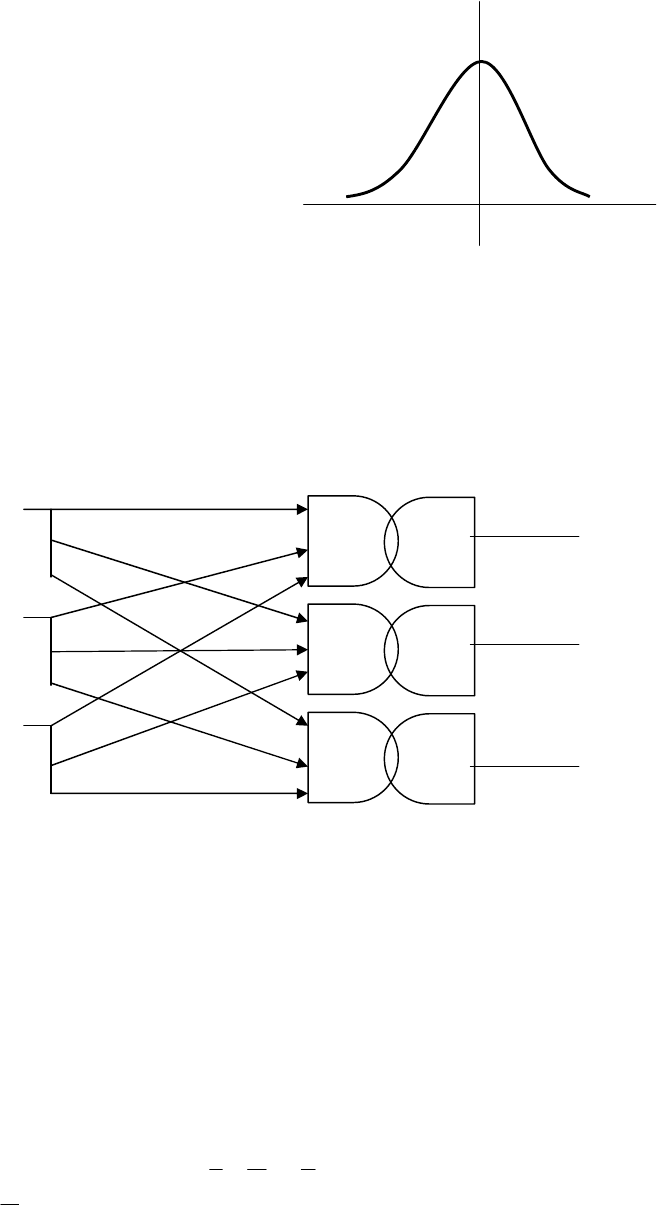

6. Функция Гаусса

2

)*5,0()( netextnetf −=

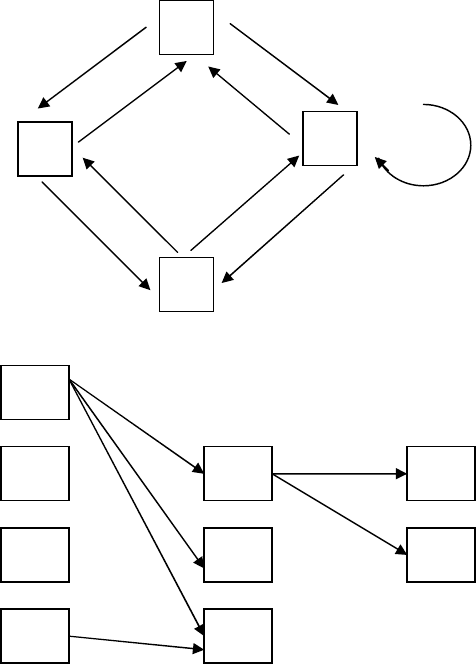

8.4 Однослойный персептрон

Пример структуры однослойной нейронной сети (персептрона ) с ‘n’-входами и ’m’-

выходами, рис.8.7

∑

=

−=

n

i

jiijj

VXWY

1

в общем случае XYV любые

Для двоичных нейтронов

<

≥

=

∑

∑

n

jiij

n

i

jij

j

VXW

VW

Y

1

,0

,1

В векторной форме VWY

ij

−= ,

X

- это образ, который надо распознать . Распознавание в геометрическом

представлении это выделение групп (областей) точек в многомерном пространстве

образов по классификационным признакам Y

j

. Например, разделение пространства

образов линией или несколькими линиями для двумерного образа ,- проведение

net

1

V

1

net

j

V

j

net

m

V

m

Y

1

Yj

Y

m

Рис 8.7

X

1

X

j

X

n

W

11

W

1j

W

1m

W

1j

W

ij

W

im

W

n1

W

nj

W

nm

плоскостей или поверхностей для 3-х мерного образа . Говорят о персептронной

представляемости – способности научиться распознавать моделировать определённые

функции, образы.

Однослойный персептрон – линейный, т.к. разделяющая образы поверхность является

либо прямой линией, либо плоскостью, либо гиперплоскостью.

Нелинейные задачи (для криволинейных линий и поверхностей раздела ) однослойному

персептрону непосильны.

Говорят о линейной неразделимости пространства признаков

X

.

Обучение или конструирование персептрона (и нейронной сети ) это процедура

настройки весов W

ij

и в общем случае и V

i

.

Обучаемостью называется наличие процедуры (алгоритма) настройки весов.

Заметим, что для однослойного персептрона с n-двоичными входами пространства

признаков

X

имеется 2

n

различных комбинаций входных сигналов. А количество образов

(функций) для распознавания Y

j

равно (2)

2^n

.Из них количество функций (образов)

линейно разделимых персептроном значительно меньше, табл. 8.1. Для остающихся

нелинейных задач распознавания требуются многослойные нейронные сети (часто с

обратными связями)

Табл.8.1

N (2)

2^n

Количество линейно

разделимых функций

1 4 4

2 16 14

3 256 104

4 65536 1882

5 4,3*10

9

94572

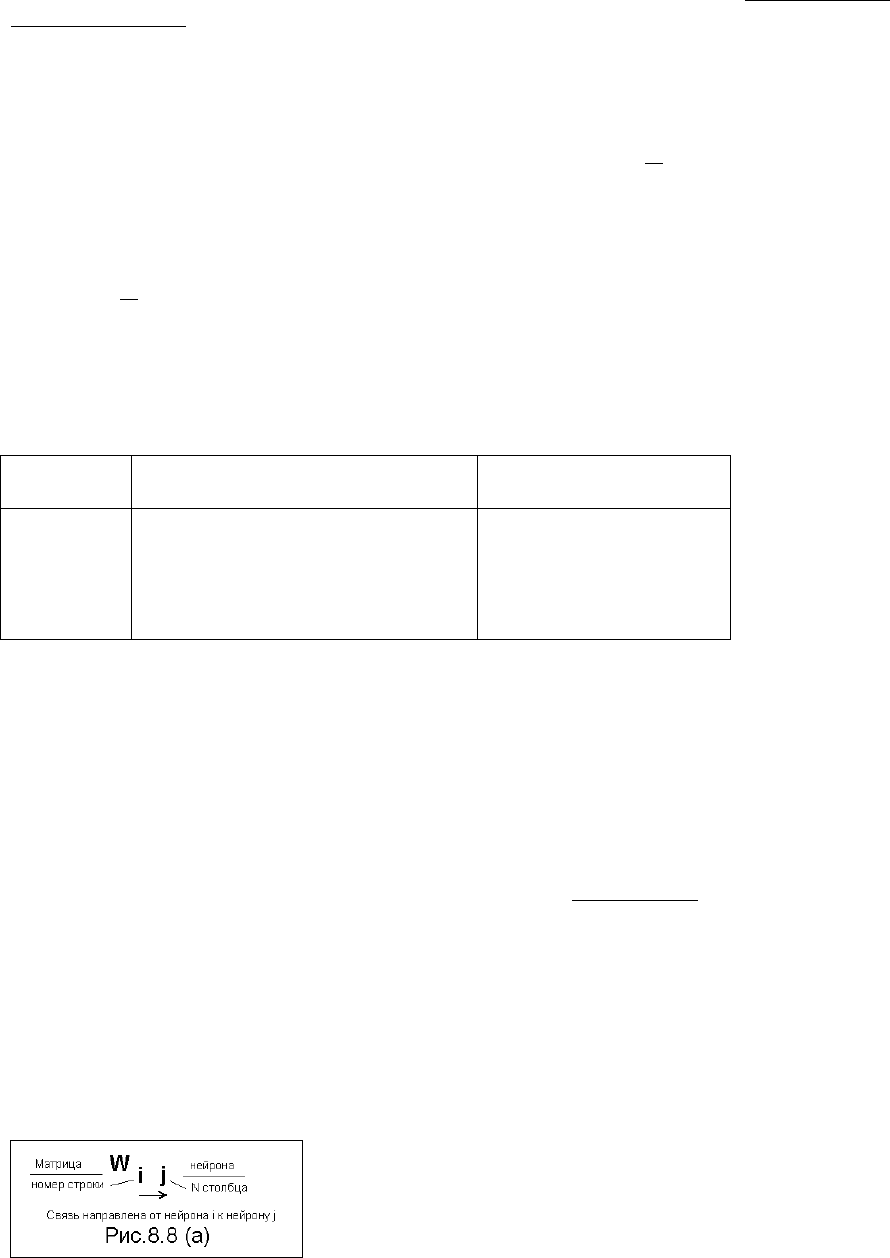

8.5 Общие принципы и основные компоненты нейронных сетей

Нейронная сеть (НС) – это устройство параллельных вычислений из множества

взаимодействующих простых «процессов» (нейронов).Нейроны периодически получает

сигналы и перерабатывает их периодически посылает свои сигналы другим другим

нейронам, объединенным множеством связей в нейронной сети .

Задача, которую понимает НС описывается в терминах весовых значений связей

между Нейронами. Эти матрицы весов связей и являются памятью НС .

О том как должна решаться выполняемая задача .

Весовые коэффициенты можно определить (построить НС) и без обучения , но главное

преимущество НС в способности обучаться.

Структура связей НС может быть самой разнообразной. Один элемент связан со всеми

другими, элементы организованы по слоям иерархически могут быть обратные связи ,

латеральные (параллельные )- возможности конструирования связей безграничны.

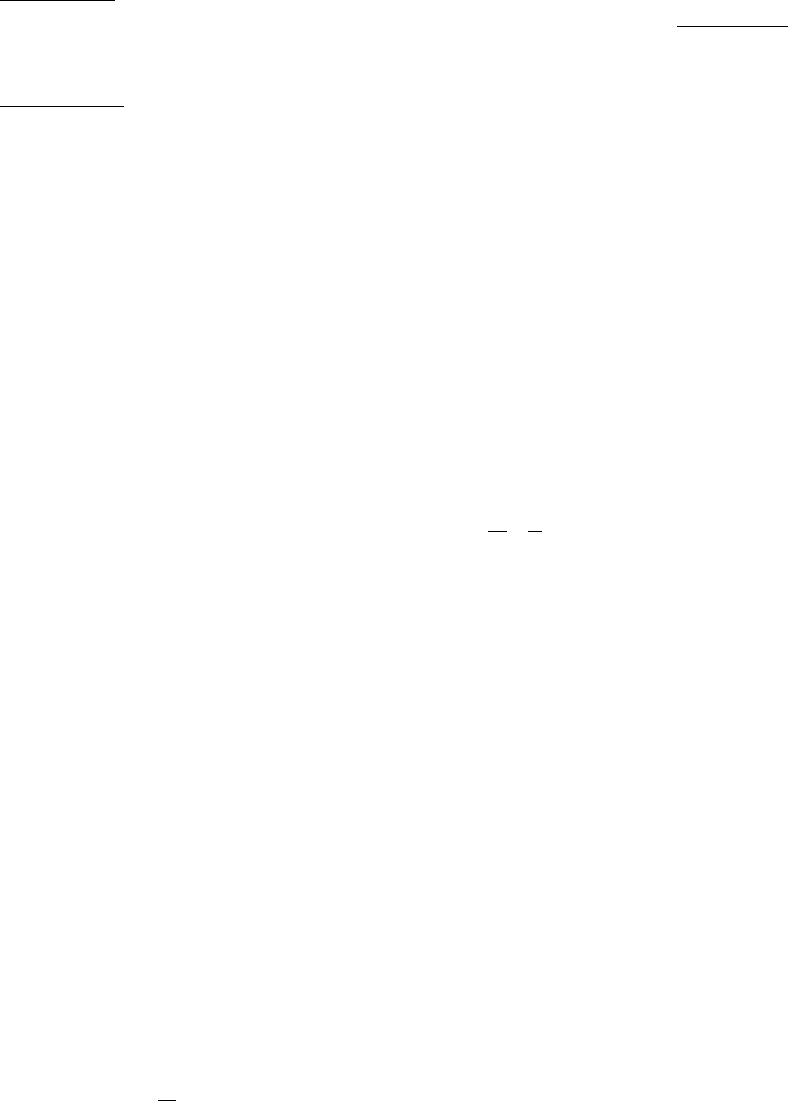

Матрицы весов (примеры)

W

1

- матрица 4х3 первого слоя нейронов

W

2

–матрица 3х2 второго слоя нейронов

−

−−

−

=

03,217,0

9,04,008,0

5,0002,1

03,46,20

W

−

=

1,0..

...

...

7,12,16,0

1

W

=

..

..

8,03,1

2

W

Рис 8.8(в)

8.6 Обучение нейронной сети

Сеть обучается чтобы для некоторого множества входов давать желаемое множество

выходов. Обучение происходит последовательным предъявлением входных векторов с

одновременной подстройкой весов по заданной процедуре. В результате веса становятся

такими , что на каждый входной вектор вырабатывается требуемый выходной. По

способу контроля ошибки и подстройки весов различают обучение с учителем и без него .

1

2

3

4

-

2,6

4,3

1,2

0,8

0,9

0,5

-

1,0

2,3

0,4

1

2

3

4

1

2

3

1

2

Рис 8.8(б )

-

0,6

1,2

-

1,7

0,1

1,3

-

0,8

W

1

(4x3)

W

2

(3x2)

.

.

.

.

.

.

.

.

.

.

С учителем. Учителю известен для каждого входного вектора требуемый выходной

целевой вектор – обучающая пары. Сравнением вычисляются ошибки и настройкой весов

минимизируются. Популярны 2-а метода δ-правило и способ обратного распространения

ошибки.

Без учителя. При предъявлении входных векторов НС самоорганизуется путем

настройки своих весов по заданному алгоритму так, что предъявления достаточно близких

входных векторов даёт одинаковые выходы , т.е . НС группирует сходные входные

векторы в классы. После обучения все выходные нейроны возбуждаются, а нейрон с

максимальным возбуждением ассоциирует с данным классом и , хотя целевых векторов

нет НС будет отображать существенные характеристики обучающего набора.

Для программной реализации используют два класса алгоритмов.

Детерминистические : НС пошагово корректирует веса определяемые выходом и

алгоритмом. Стохастические не изменяет веса псевдослучайно , сохраняя те , которые

ведут к уменьшению ошибки . Достоинства : снимается проблема глобального минимума и

возможное отсутствие сходимости сети при малых шагах изменения весов. Недостаток: по

сравнении с детерминистическим алгоритмом – длительность процесса обучения.

Пример алгоритма обучения методом δ- правила

Сначала :

- Выбираем уровень допустимости ошибки ε

0

.Для двоичных выходов можно

выбрать ε

0

=0. Составим таблицу обучающих пар

Y

X

−

1. Задаем случайную матрицу весов небольших значений (-0,3… +0,3) входной

целевой

2. Предъявляем любой вход (вектор входа ) и вычисляем вектор ответа НС

Y

j

НС

3. Вычислим вектор ошибок δ

j

=Y

j

-Y

j

НС

4. Изменяем веса W

ij

=W

ij

+ηε

j

X

i

η-коэф . Скорости обучения лежит в

диапазоне 0<η<=1

5. Вычисляем суммарную ошибку

∑

=

m

j

de

m – количество выходов НС

6. если ε>ε

0

идем на шаг 2 иначе завершаем обучение .

7. Тестируем НС входом не входящим во множество векторов обучения.

8.7 Примеры тестирования простых НС

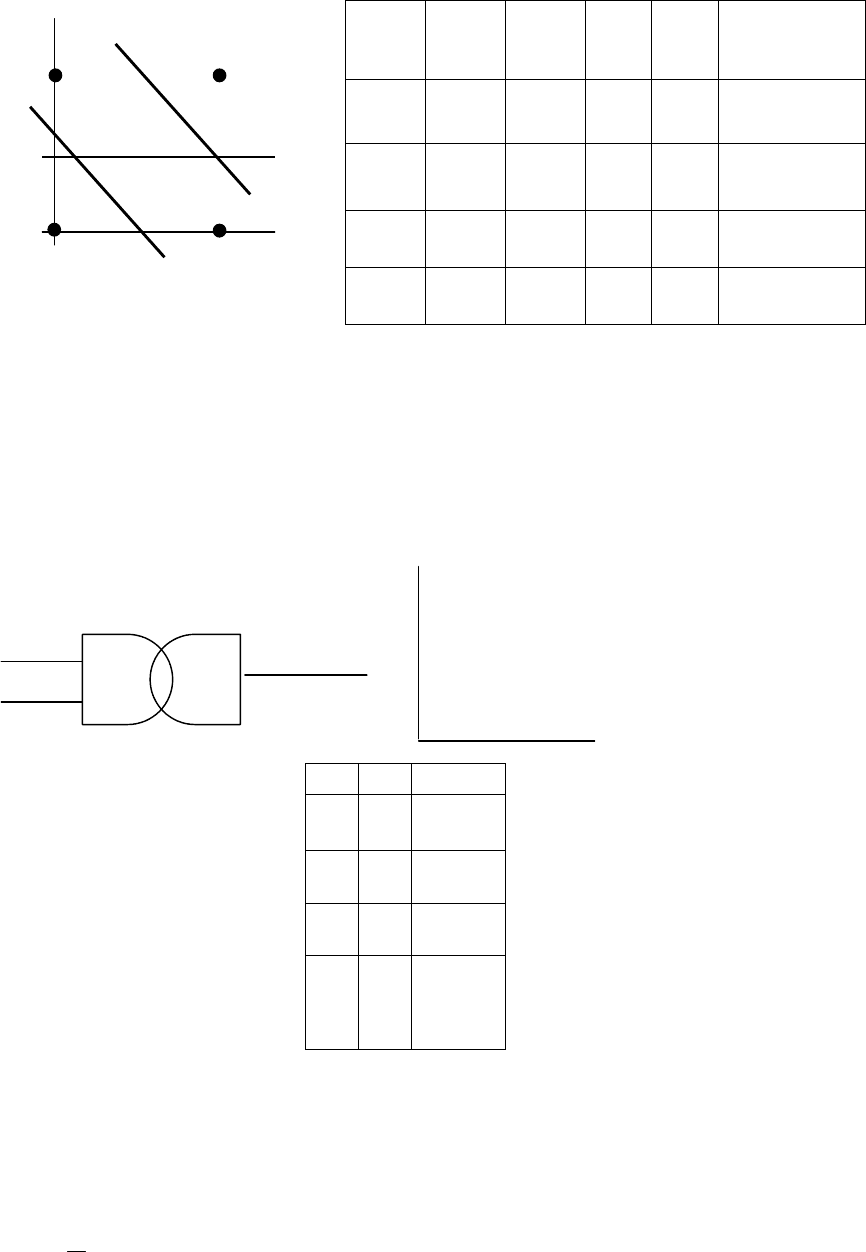

Удобно проводить с помощью геометрических представлений.

Входной вектор

X

это группа (область ) точек в многомерном пространстве .

Распознавание (классификация) это объединение точек или областей образов по

классификационным признакам Y

j

. Например проведение одной или нескольких прямых

(линейная НС) для двумерного образа (входного вектора) или плоскостей (поверхностей)

для трёхмерного образа или плоскостей, криволинейных поверхностей для n>3 мерного

образа .

net V

Y

X

1

W

1

X

2

W

2

X

2

1 * b d*

X

1

0 * a c*

- Распознавание логических функций

число Х

1

Х

2

а

ИЛ

И

b

И

c

Чет - нечет

0 0 0 0 0 1

1 0 1 1 0 0

2 1 0 1 0 1

3 1 1 1 1 0

Эти задачи под силу однослойному персептрону

a – прямая разграничения функции ИЛИ

b – прямая разграничения функции И

c – прямая разграничения функции «чёт-нечёт»

Однослойный персептрон с двумя двоякими входами способен различать 14 из 16

логических суждений кроме функций «исключительное ИЛИ» и «исключительной ИЛИ-

НЕ»

Рассмотрим ещё некоторые функции.

Х

1

Х

2

точки

0 0 a

0 1 b

1 0 c

1 1 d

net = X

1

W

1

+X

2

W

2

;

<

≥

=

Vnet

Vnet

Y

,0

,1

Возьмем V=0,5. Все точки отвечающие условию V=0,5 лежат на прямой

X

1

W

1

+X

2

W

2

=0,5. Выбирая W

1

и W

2

получим прямые разграничивающие на плоскости

признаков

X

заданные логические функции Y

j

, рисунки

Чет-нечёт

ИЛИ

a 10(2)

b

11(3)

X

1

X

2

01(1)

00(0)

И

Рис. 8.10 (а , б )

2

1

1

22

1

1

2

2

5,0

W

W

X

WW

W

X

W

V

X −=−=

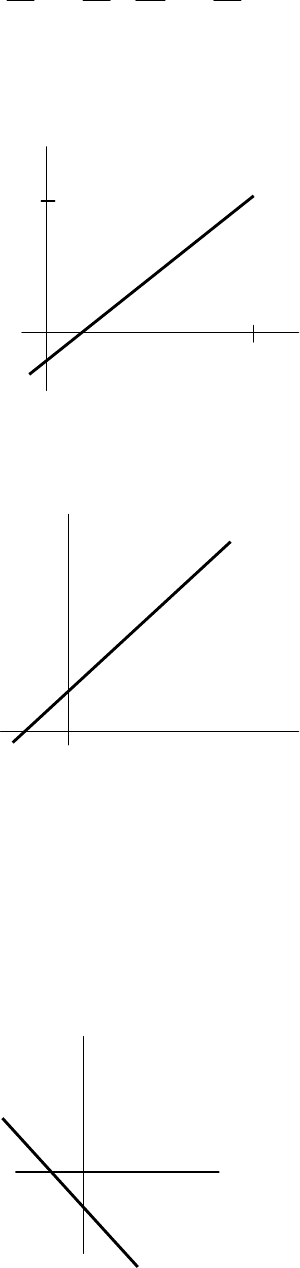

1. Для W

1

= +1 , W

2

= -1; X

2

= -0,5 + X

1

;

2. Для W

1

= -1 , W

2

= 1; X

2

= 0,5 + X

1

;

3. Для W

1

= -1 , W

2

= -1; X

2

= -0,5 - X

1

;

X

2

Y=0

1

Рис 8.11(а )

0 1

Y=1

X

1

1 X

1

X

2

1

0

Y=1

Y=0

Рис 8.11(б )

Y=1 Y=0

X

2

1

0 1 X

1

Рис 8.11(в)

4. Для W

1

= 1 , W

2

= 1; X

2

= 0,5 - X

1

;

5. Возьмем V=1,5 W

1

= 1 , W

2

= 1; X

2

=1,5 - X

1

;

Y=0

Y=1

X

2

1

0 1 X

1

Рис 8.11(г)

X

1

X

2

1

1

Y=0 Y=1

Рис 8.11(д)

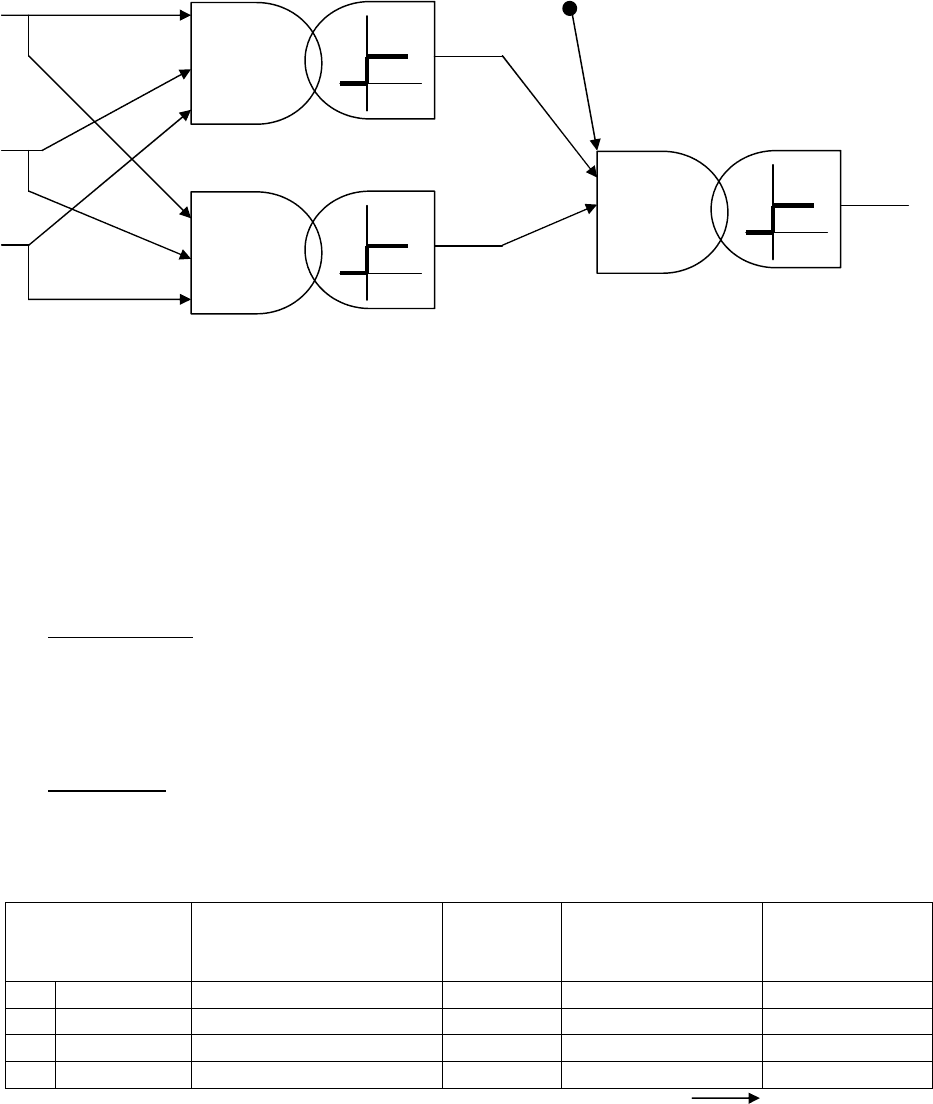

1–й слой 2–й слой

Рис 8.12

net

12

2

net

11

1

net

2

Y

2

Y

11

Y

12

-

0.5

+1

-1

X

0

=1

X

0

=0 1.5

0.5

X

1

-1

-1

X

2

-1

-1

Проблема XOR

Точки (числа ) 1 и 2 надо отделить от точек 0 и 3. Одной прямой это сделать

невозможно . Но двумя прямыми можно . Следовательно , необходимо двух – слоеная

нейронная сеть , рис.8.12.

<

≥

=

0,0

0,1

)(

net

net

netf

Матрица 1-го слоя

−−

−−=

11

11

5,05,1

1

W

Матрица 2-го слоя

−

−

=

1

1

5,0

2

W

Тестирование

Входной

вектор

Комбинированный

вход 1-го слоя

net

11

net

12

Выход 1-

го слоя

Y

11

Y

12

Комбинированны

й вход 2-го net

2

Выход 2-го

слоя Y

2

1 11 [-0,5 -1,5] [0 1] -0,5 0

1 10 [0,5 -0,5] [1 0] 0,5 1

1 01 [-0,5 -0,5] [1 0] 0,5 1

1 00 [1,5 0,5] [1 1] -0,5 0

Функция XOR